Diferencia entre revisiones de «Distribución binomial»

Sin resumen de edición |

m Revertida una edición de 132.248.139.94 (disc.) a la última edición de SeroBOT Etiqueta: Reversión |

||

| (No se muestran 43 ediciones intermedias de 26 usuarios) | |||

| Línea 1: | Línea 1: | ||

{{Redirige aquí|Binomial|binomial (desambiguación)}} |

{{Redirige aquí|Binomial|binomial (desambiguación)}} |

||

{{referencias|t=20141224163111}} |

|||

{{Ficha de distribución de probabilidad |

{{Ficha de distribución de probabilidad |

||

|nombre = Distribución binomial |

|nombre = Distribución binomial |

||

| Línea 16: | Línea 15: | ||

|varianza = <math>np(1-p)\!</math> |

|varianza = <math>np(1-p)\!</math> |

||

|simetría = <math>\frac{1-2p}{\sqrt{np(1-p)}}\!</math> |

|simetría = <math>\frac{1-2p}{\sqrt{np(1-p)}}\!</math> |

||

|curtosis = <math>\frac{1-6p(1-p)}{np(1-p)}\!</math> |

|curtosis = <math>\frac{1-6p(1-p)}{np(1-p)}+3\!</math> |

||

|entropía = <math> \frac{1}{2} \ln \left( 2 \pi n e p (1-p) \right) + O \left( \frac{1}{n} \right) </math> |

|entropía = <math> \frac{1}{2} \ln \left( 2 \pi n e p (1-p) \right) + O \left( \frac{1}{n} \right) </math> |

||

|mgf = <math>(1-p + pe^t)^n \!</math> |

|mgf = <math>(1-p + pe^t)^n \!</math> |

||

| Línea 22: | Línea 21: | ||

}} |

}} |

||

En [[teoría de la probabilidad]] y [[estadística]], la '''distribución binomial''' o '''distribución binómica''' es una [[distribución de probabilidad]] discreta que cuenta el número de éxitos en una secuencia de <math>n</math> ensayos de [[Experimento de Bernoulli|Bernoulli]] independientes entre sí con una probabilidad fija <math>p</math> de ocurrencia de éxito entre los ensayos. Un experimento de Bernoulli se caracteriza por ser [[Dicotomía|dicotómico]], esto es, solo dos resultados son posibles, a uno de estos se le denomina “éxito” y tiene una probabilidad de ocurrencia <math>p</math> y al otro se le denomina “fracaso” y tiene una probabilidad <math>q=1-p</math>. |

En [[teoría de la probabilidad]] y [[estadística]], la '''distribución binomial''' o '''distribución binómica''' es una [[distribución de probabilidad]] discreta que cuenta el número de éxitos en una secuencia de <math>n</math> ensayos de [[Experimento de Bernoulli|Bernoulli]] independientes entre sí con una probabilidad fija <math>p</math> de ocurrencia de éxito entre los ensayos. Un experimento de Bernoulli se caracteriza por ser [[Dicotomía|dicotómico]], esto es, solo dos resultados son posibles, a uno de estos se le denomina “éxito” y tiene una probabilidad de ocurrencia <math>p</math> y al otro se le denomina “fracaso” y tiene una probabilidad <math>q=1-p</math>.<ref>{{cite book |last=Wadsworth |first=G. P. |title=Introduction to Probability and Random Variables |year=1960 |publisher=McGraw-Hill |location=New York |page=[https://archive.org/details/introductiontopr0000wads/page/52 52] |url=https://archive.org/details/introductiontopr0000wads }}</ref> |

||

La distribución binomial se utiliza con frecuencia para modelizar el número de aciertos en una muestra de tamaño ''n'' extraída [[con reemplazo]] de una población de tamaño ''N''. Si el muestreo se realiza sin reemplazo, las extracciones no son independientes, por lo que la distribución resultante es una [[distribución hipergeométrica]], no una distribución binomial. Sin embargo, para ''N'' mucho mayores que ''n'', la distribución binomial sigue siendo una buena aproximación, y se utiliza ampliamente. |

|||

| ⚫ | |||

Más matemáticamente, la distribución binomial es una [[distribución discreta de probabilidad]] descrita por dos parámetros: {{math|''n''}} el número de experimentos realizados, y {{math|''p''}} la probabilidad de éxito. Para cada experimento llamado [[ensayo Bernoulli]], utilizamos una [[variable aleatoria]] que toma el valor {{math|1}} cuando se consigue un éxito y el valor {{math|0}} en caso contrario. La variable aleatoria, suma de todas estas variables aleatorias, cuenta el número de éxitos y sigue una distribución binomial. Es posible entonces obtener la probabilidad de {{math|''k''}} éxitos en una repetición de {{math|''n''}} experimentos: |

|||

:<math>\mathbb{P}(X = k)= {n \choose k} \, p^k (1-p)^{n-k}.</math> |

|||

En esta fórmula interviene el [[coeficiente binomial]] <math>{n\choose k}</math> del que se deriva el nombre de la ley. |

|||

La importancia de esta ley es en primer lugar histórica ya que fue objeto de estudio del [[Teorema de De Moivre-Laplace]], resultado del {{s-|xviii|e}} fundador de la [[Teoría de la probabilidad#Convergencias y resultados límite|teoremas de convergencia]]. Una distribución binomial también se puede utilizar para modelar situaciones simples de acertar o fallar, un juego de [[Cara o cruz| lanzar una moneda]], por ejemplo. El cálculo de su [[función de probabilidad]] se vuelve rápidamente tedioso cuando {{math|''n''}}} es grande, es posible entonces utilizar aproximaciones por otras [[Distribución de probabilidad| leyes de probabilidad|leyes de probabilidad]] como la [[distribución de Poisson]] o la [[distribución normal]] y utilizar tablas de valores. |

|||

La ley binomial se utiliza en diversos campos de estudio, especialmente a través de [[Contraste de hipótesis|pruebas estadísticas]] que permiten interpretar datos y tomar decisiones en situaciones que dependen del azar. Debido a su sencilla definición, es una de las leyes de probabilidad que se estudian en los cursos introductorios de teoría de la probabilidad. |

|||

== Explicación intuitiva == |

|||

[[File:Pile ou face.png|thumb|vignette|Cara o cruz|199x199px]] |

|||

=== Primeros ejemplos === |

|||

==== Cara o cruz ==== |

|||

Consideremos ''n'' lanzamientos sucesivos de una moneda. Entonces el número de veces que la moneda aparece en la cara de la cruz sigue la distribución binomial donde el número de experimentos realizados es ''n'' y la probabilidad de éxito es <math>p = \frac 1 2</math> |

|||

==== Lanzar un dado ==== |

|||

Consideremos ''n'' lanzamientos sucesivos de un dado de 6 caras. Entonces el número de veces que sale un 1 sigue la distribución binomial donde el número de experimentos realizados es ''n'' y la probabilidad de éxito es <math>p = \frac 1 6</math>. |

|||

=== Definición intuitiva === |

|||

Una [[Distribución Bernoulli| ley de Bernoulli]] describe el comportamiento de un [[experimento aleatorio]] que tiene dos posibles resultados tradicionalmente llamados éxito y fracaso<ref name="gossett310">{{Harvsp|Gossett|2009|p=310}}.</ref>. Un experimento de este tipo se denomina [[ensayo de Bernoulli]]. Por ejemplo, en un lanzamiento de [[cara o cruz]], cara puede considerarse un éxito y cruz un fracaso. En este modelo, la probabilidad de éxito es un valor fijo, es decir, permanece constante en cada renovación del experimento aleatorio. Esta probabilidad de éxito se denomina "p". |

|||

Consideremos la situación en la que un experimento aleatorio de este tipo (dos resultados posibles y una probabilidad fija) se repite un cierto número de veces de forma independiente; denotemos {{math|''n''}} este número de veces. Esta repetición independiente de ensayos de Bernoulli se denomina [[ensayo de Bernoulli#Esquema de Bernoulli|Esquema de Bernoulli]] o simplemente [[ensayo de Bernoulli|Ensayos de Bernoulli]]<ref name="dodge175">{{Harvsp|Dodge|2007|p=175}}.</ref>. Una distribución binomial describe el número de veces que aparece el ''éxito'' en los {{math|''n''}} experimentos realizados. Dado que el número de éxitos obtenidos es un valor aleatorio, una distribución binomial se describe dando las probabilidades de que el éxito se produzca precisamente {{math|''k''}} veces en los {{math|''n''}} ensayos. |

|||

=== Árbol de probabilidades === |

|||

[[File:Wiki arbre.svg|vignette|alt=arbre de probabilité|upright=1.5|[[Arbre de probabilité]] pour une loi binomiale associée à 3 épreuves de Bernoulli.|gauche]] |

|||

Una forma visual de representar una secuencia de experimentos es utilizar un [[árbol de probabilidad]]. Cada suceso está representado por dos ramas: una para el éxito y otra para el fracaso. En cada extremo, se añaden dos ramas (éxito y fracaso) para el siguiente ensayo. Esto se repite hasta que se alcanza el número total de sucesos. En cada extremo final, se puede contar el número de éxitos. Se multiplica el número de veces que {{math|''k''}} tiene éxito por la probabilidad de que {{math|''k''}} tenga éxito para obtener la probabilidad correspondiente de la distribución binomial. |

|||

| ⚫ | |||

=== Notación === |

=== Notación === |

||

Si una |

Si una variable aleatoria discreta <math>X</math> tiene una distribución binomial con parámetros <math>n\in\mathbb{N}</math> y <math>p</math> con <math>0<p<1</math> entonces escribiremos <math>X\sim\operatorname{Bin}(n,p)</math>. |

||

=== Función de Probabilidad === |

=== Función de Probabilidad === |

||

Si <math>X\sim\operatorname{Bin}(n,p)</math> entonces su |

Si <math>X\sim\operatorname{Bin}(n,p)</math> entonces su función de probabilidad está dada por |

||

:<math>\operatorname{P}[X=x]={n \choose x}p^x(1-p)^{n-x}</math> |

:<math>\operatorname{P}[X=x]={n \choose x}p^x(1-p)^{n-x}</math> |

||

| Línea 38: | Línea 60: | ||

:<math>\!{n \choose x} = \frac{n!}{x!(n-x)!} \,\!</math> |

:<math>\!{n \choose x} = \frac{n!}{x!(n-x)!} \,\!</math> |

||

el [[coeficiente binomial]] y se lee “las combinaciones de <math>n \,\!</math> en <math>x \,\!</math>“. |

el [[coeficiente binomial]] y se lee “las [[Combinación (matemáticas)|combinaciones]] de <math>n \,\!</math> en <math>x \,\!</math>“. |

||

En ocasiones, para calcular las probabilidades binomiales se utiliza la siguiente fórmula recursiva para calcular <math>\operatorname{P}[X=x+1]</math> en términos de <math>\operatorname{P}[X=x]</math> |

En ocasiones, para calcular las probabilidades binomiales se utiliza la siguiente fórmula recursiva para calcular <math>\operatorname{P}[X=x+1]</math> en términos de <math>\operatorname{P}[X=x]</math> |

||

| Línea 65: | Línea 87: | ||

&=\operatorname{P}[X\leq x] \\ |

&=\operatorname{P}[X\leq x] \\ |

||

&=I_{1-p}(n-x,x+1) \\ |

&=I_{1-p}(n-x,x+1) \\ |

||

&=(n-x){n\choose x}\int_0^{1-p}t^{n-x-1}(1-t)^ |

&=(n-x){n\choose x}\int_0^{1-p}t^{n-x-1}(1-t)^xdt |

||

\end{align}</math> |

\end{align}</math> |

||

| Línea 81: | Línea 103: | ||

=== Ejemplo === |

=== Ejemplo === |

||

| ⚫ | |||

| ⚫ | |||

En este problema un ensayo consiste en lanzar el dado una vez. Consideramos un éxito si obtenemos un 3 pero si no sale 3 lo consideramos como un fracaso. Defínase <math>X</math> como el número de veces que se obtiene un 3 en 51 lanzamientos. |

En este problema un ensayo consiste en lanzar el dado una vez. Consideramos un éxito si obtenemos un 3 pero si no sale 3 lo consideramos como un fracaso. Defínase <math>X</math> como el número de veces que se obtiene un 3 en 51 lanzamientos. |

||

En este caso tenemos <math>X\sim\operatorname{Bin}(51,1/6)</math> por lo que la probabilidad buscada es <math>\operatorname{P}[X=20]</math> |

En este caso tenemos <math>X\sim\operatorname{Bin}(51, 1/6)</math> por lo que la probabilidad buscada es <math>\operatorname{P}[X=20]</math> |

||

:<math>\operatorname{P}[X=20]={51 \choose 20}(1/6)^{20}(1-1/6)^{51-20}=0.0000744 \,\!</math> |

:<math>\operatorname{P}[X=20]={51 \choose 20}(1/6)^{20}(1-1/6)^{51-20}=0.0000744 \,\!</math> |

||

| Línea 173: | Línea 194: | ||

:<math>\sum_{i=1}^kX_i \sim\operatorname{Bin}\left(\sum_{i=1}^kn_i, p\right)</math> |

:<math>\sum_{i=1}^kX_i \sim\operatorname{Bin}\left(\sum_{i=1}^kn_i, p\right)</math> |

||

== Inferencia estadística == |

|||

=== Estimación de parámetros === |

|||

Cuando se conoce ''n'', el parámetro ''p'' puede estimarse utilizando la proporción de aciertos: |

|||

:<math> \widehat{p} = \frac{x}{n}.</math> |

|||

Este estimador se encuentra utilizando [[Máxima verosimilitud| estimador de máxima verosimilitud]] y también el [[Método de momentos (estadística)|método de los momentos]]. Este estimador es [[Sesgo estadístico|insesgado]] y uniforme con [[Estimador insesgado de varianza mínima|mínima varianza]], demostrado mediante el [[Teorema de Lehmann–Scheffé]], ya que se basa en un estadístico [[Suficiencia (estadística)| mínimo suficiente]] y [[Completitud (estadística)|completo]] (es decir: ''x''). También es [[Estimador consistente|consistente]] tanto en probabilidad como en [[Error cuadrático medio|MSE]]. |

|||

También existe un [[estimador de Bayes]] de forma cerrada para ''p'' cuando se utiliza la [[distribución Beta]] como [[conjugada]] de la [[probabilidad a priori]]. Cuando se utiliza un <math>\operatorname{Beta}(\alpha, \beta)</math> ''a priori'', el estimador medio posterior es: |

|||

:<math> \widehat{p}_b = \frac{x+\alpha}{n+\alpha+\beta}.</math> |

|||

El estimador de Bayes es asintóticamente eficiente y a medida que el tamaño de la muestra se aproxima a infinito (''n'' → ∞), se aproxima a la solución de [[máxima verosimilitud]]. El estimador de Bayes es [[Sesgo estadístico|sesgado]], cuánto depende de los priores, admisible y [[Consistencia (estadística)|consistente]] en probabilidad. |

|||

Para el caso especial de utilizar la [[Distribución uniforme continua#Función de distribución| distribución uniforme estándar]] como a [[Probabilidad a priori| priori no informativo]], <math>\operatorname{Beta}(\alpha=1, \beta=1) = U(0,1)</math>, el estimador de la media ''a posteriori'' se convierte en: |

|||

:<math> \widehat{p}_b = \frac{x+1}{n+2}.</math> |

|||

Este método se denomina [[regla de sucesión]], que fue introducido en el {{siglo|XVIII||s}} por [[Pierre-Simon Laplace]]. |

|||

Cuando se estima ''p'' con sucesos muy raros y un ''n'' pequeño (por ejemplo: si x=0), entonces utilizar el estimador estándar conduce a <math> \widehat{p} = 0,</math> lo que a veces es poco realista y poco deseable. En estos casos existen varios estimadores alternativos.<ref>{{cite journal |last=Razzaghi |first=Mehdi |title=Sobre la estimación de la probabilidad de éxito binomial con ocurrencia cero en la muestra |journal=Journal of Modern Applied Statistical Methods |volume=1 |issue=2 |year=2002 |pages=326-332 |doi=10.22237/jmasm/1036110000 |doi-access= }}</ref> Una forma es utilizar el estimador de Bayes, lo que lleva a: |

|||

:<math> \widehat{p}_b = \frac{1}{n+2}.</math> |

|||

Otro método consiste en utilizar el límite superior del [[intervalo de confianza]] obtenido mediante la [[Regla de tres (estadística)|regla de tres]]: |

|||

:<math> \widehat{p}_{\text{rule of 3}} = \frac{3}{n}.</math> |

|||

=== Intervalos de confianza=== |

|||

Incluso para valores bastante grandes de ''n'', la distribución real de la media es significativamente no normal.<ref name=Brown2001>{{Citation |first1=Lawrence D. |last1=Brown |first2=T. Tony |last2=Cai |first3=Anirban |last3=DasGupta |year=2001 |title = Estimación de intervalos para una proporción binomial |url=http://www-stat.wharton.upenn.edu/~tcai/paper/html/Binomial-StatSci. html |journal=Statistical Science |volume=16 |issue=2 |pages=101-133 |access-date = 2015-01-05 |doi=10.1214/ss/1009213286|citeseerx=10.1.1.323.7752 }}</ref> Debido a este problema se han propuesto varios métodos para estimar intervalos de confianza. |

|||

En las ecuaciones para intervalos de confianza que se presentan a continuación, las variables tienen el siguiente significado: |

|||

* ''n'' <sub>1</sub> es el número de aciertos de ''n'', el número total de ensayos. |

|||

* <math> \widehat{p\,} = \frac{n_1}{n}</math> es la proporción de aciertos |

|||

* <math>z=1 - \tfrac{1}{2}\alpha</math> es el [[cuantil]] de una [[Distribución normal| distribución normal estándar]] (es decir, [[probit]]) correspondiente a la tasa de error objetivo <math>\alpha</math>. Por ejemplo, para un [[nivel de confianza]] del 95% el error <math>\alpha</math> = 0,05, por lo que <math>1 - \tfrac{1}{2}\alpha</math> = 0,975 y <math>z</math> = 1,96. |

|||

== Véase también == |

== Véase también == |

||

| Línea 184: | Línea 231: | ||

== Referencias == |

== Referencias == |

||

{{listaref}} |

{{listaref}} |

||

== Bibliografía== |

|||

*{{cite book |first=Werner Z. |last=Hirsch |title=Introduction to Modern Statistics |location=New York |publisher=MacMillan |year=1957 |chapter=Binomial Distribution—Success or Failure, How Likely Are They? |pages=140–153 |chapter-url=https://books.google.com/books?id=KostAAAAIAAJ&pg=PA140 }} |

|||

*{{cite book |first1=John |last1=Neter |first2=William |last2=Wasserman |first3=G. A. |last3=Whitmore |title=Applied Statistics |url=https://archive.org/details/appliedstatistic0000nete |location=Boston |publisher=Allyn & Bacon |edition=Third |year=1988 |isbn=0-205-10328-6 |pages=[https://archive.org/details/appliedstatistic0000nete/page/185 185]–192 }} |

|||

*{{cite book|autor=Patrick Bogaert|título=Probabilités pour scientifiques et ingénieurs|editorial=[[De Boeck Supérieur]]|year=2005|pages=402|isbn=2-8041-4794-0|lire en ligne=}} |

|||

== Enlaces externos == |

== Enlaces externos == |

||

{{commonscat|Binomial distributions}} |

{{commonscat|Binomial distributions}} |

||

* [https://sigmalitika.hirusta.io/recurso/tablas-de-la-distribucion-binomial/ Tablas de la distribución binomial], hasta n=20, en formato PDF. |

* [https://sigmalitika.hirusta.io/recurso/tablas-de-la-distribucion-binomial/ Tablas de la distribución binomial], hasta n=20, en formato PDF. |

||

| Línea 192: | Línea 242: | ||

* [https://web.archive.org/web/20131014011948/http://cajael.com/mestadisticos/T6DDiscretas/node2.php Cálculo de la probabilidad de una distribución binomial] con [[R (lenguaje de programación)]] |

* [https://web.archive.org/web/20131014011948/http://cajael.com/mestadisticos/T6DDiscretas/node2.php Cálculo de la probabilidad de una distribución binomial] con [[R (lenguaje de programación)]] |

||

* [https://www.aglarick.com/2020/02/18/generar-la-distribucion-binomial-con-numeros-aleatorios/ Generación estadística de la distribución binomial con números aleatorios] usando [[Python|Python (lenguaje de programación)]] |

* [https://www.aglarick.com/2020/02/18/generar-la-distribucion-binomial-con-numeros-aleatorios/ Generación estadística de la distribución binomial con números aleatorios] usando [[Python|Python (lenguaje de programación)]] |

||

* Interactive graphic: [http://www.math.wm.edu/~leemis/chart/UDR/UDR.html Univariate Distribution Relationships] |

|||

* [http://www.fxsolver.com/browse/formulas/Binomial+distribution Binomial distribution formula calculator] |

|||

* Difference of two binomial variables: [https://math.stackexchange.com/q/1065487 X-Y] or [https://math.stackexchange.com/q/562119 |X-Y|] |

|||

* [http://www.wolframalpha.com/input/?i=Prob+x+%3E+19+if+x+is+binomial+with+n+%3D+36++and+p+%3D+.6 Querying the binomial probability distribution in WolframAlpha] |

|||

{{Control de autoridades}} |

{{Control de autoridades}} |

||

[[Categoría:Distribuciones discretas|Binomial]] |

[[Categoría:Distribuciones discretas|Binomial]] |

||

[[Categoría:Temas factoriales y binomiales]] |

|||

Revisión actual - 13:52 16 oct 2024

| Distribución binomial | ||

|---|---|---|

|

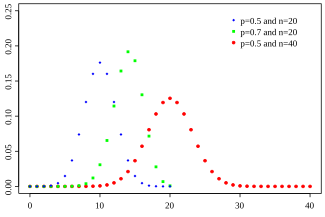

Función de masa de probabilidad Función de probabilidad | ||

|

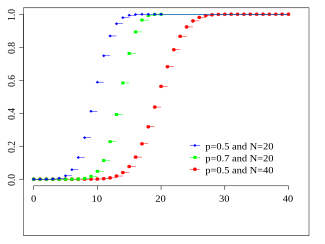

Función de distribución acumulada Función de distribución de probabilidad | ||

| Parámetros |

número de ensayos (entero) probabilidad de éxito (real) | |

| Dominio | ||

| Función de probabilidad (fp) | ||

| Función de distribución (cdf) | ||

| Media | ||

| Mediana | Uno de [1] | |

| Moda | ||

| Varianza | ||

| Coeficiente de simetría | ||

| Curtosis | ||

| Entropía | ||

| Función generadora de momentos (mgf) | ||

| Función característica | ||

En teoría de la probabilidad y estadística, la distribución binomial o distribución binómica es una distribución de probabilidad discreta que cuenta el número de éxitos en una secuencia de ensayos de Bernoulli independientes entre sí con una probabilidad fija de ocurrencia de éxito entre los ensayos. Un experimento de Bernoulli se caracteriza por ser dicotómico, esto es, solo dos resultados son posibles, a uno de estos se le denomina “éxito” y tiene una probabilidad de ocurrencia y al otro se le denomina “fracaso” y tiene una probabilidad .[2]

La distribución binomial se utiliza con frecuencia para modelizar el número de aciertos en una muestra de tamaño n extraída con reemplazo de una población de tamaño N. Si el muestreo se realiza sin reemplazo, las extracciones no son independientes, por lo que la distribución resultante es una distribución hipergeométrica, no una distribución binomial. Sin embargo, para N mucho mayores que n, la distribución binomial sigue siendo una buena aproximación, y se utiliza ampliamente.

Más matemáticamente, la distribución binomial es una distribución discreta de probabilidad descrita por dos parámetros: n el número de experimentos realizados, y p la probabilidad de éxito. Para cada experimento llamado ensayo Bernoulli, utilizamos una variable aleatoria que toma el valor 1 cuando se consigue un éxito y el valor 0 en caso contrario. La variable aleatoria, suma de todas estas variables aleatorias, cuenta el número de éxitos y sigue una distribución binomial. Es posible entonces obtener la probabilidad de k éxitos en una repetición de n experimentos:

En esta fórmula interviene el coeficiente binomial del que se deriva el nombre de la ley.

La importancia de esta ley es en primer lugar histórica ya que fue objeto de estudio del Teorema de De Moivre-Laplace, resultado del xviii fundador de la teoremas de convergencia. Una distribución binomial también se puede utilizar para modelar situaciones simples de acertar o fallar, un juego de lanzar una moneda, por ejemplo. El cálculo de su función de probabilidad se vuelve rápidamente tedioso cuando n} es grande, es posible entonces utilizar aproximaciones por otras leyes de probabilidad|leyes de probabilidad como la distribución de Poisson o la distribución normal y utilizar tablas de valores.

La ley binomial se utiliza en diversos campos de estudio, especialmente a través de pruebas estadísticas que permiten interpretar datos y tomar decisiones en situaciones que dependen del azar. Debido a su sencilla definición, es una de las leyes de probabilidad que se estudian en los cursos introductorios de teoría de la probabilidad.

Explicación intuitiva

[editar]

Primeros ejemplos

[editar]Cara o cruz

[editar]Consideremos n lanzamientos sucesivos de una moneda. Entonces el número de veces que la moneda aparece en la cara de la cruz sigue la distribución binomial donde el número de experimentos realizados es n y la probabilidad de éxito es

Lanzar un dado

[editar]Consideremos n lanzamientos sucesivos de un dado de 6 caras. Entonces el número de veces que sale un 1 sigue la distribución binomial donde el número de experimentos realizados es n y la probabilidad de éxito es .

Definición intuitiva

[editar]Una ley de Bernoulli describe el comportamiento de un experimento aleatorio que tiene dos posibles resultados tradicionalmente llamados éxito y fracaso[3]. Un experimento de este tipo se denomina ensayo de Bernoulli. Por ejemplo, en un lanzamiento de cara o cruz, cara puede considerarse un éxito y cruz un fracaso. En este modelo, la probabilidad de éxito es un valor fijo, es decir, permanece constante en cada renovación del experimento aleatorio. Esta probabilidad de éxito se denomina "p".

Consideremos la situación en la que un experimento aleatorio de este tipo (dos resultados posibles y una probabilidad fija) se repite un cierto número de veces de forma independiente; denotemos n este número de veces. Esta repetición independiente de ensayos de Bernoulli se denomina Esquema de Bernoulli o simplemente Ensayos de Bernoulli[4]. Una distribución binomial describe el número de veces que aparece el éxito en los n experimentos realizados. Dado que el número de éxitos obtenidos es un valor aleatorio, una distribución binomial se describe dando las probabilidades de que el éxito se produzca precisamente k veces en los n ensayos.

Árbol de probabilidades

[editar] Una forma visual de representar una secuencia de experimentos es utilizar un árbol de probabilidad. Cada suceso está representado por dos ramas: una para el éxito y otra para el fracaso. En cada extremo, se añaden dos ramas (éxito y fracaso) para el siguiente ensayo. Esto se repite hasta que se alcanza el número total de sucesos. En cada extremo final, se puede contar el número de éxitos. Se multiplica el número de veces que k tiene éxito por la probabilidad de que k tenga éxito para obtener la probabilidad correspondiente de la distribución binomial.

Una forma visual de representar una secuencia de experimentos es utilizar un árbol de probabilidad. Cada suceso está representado por dos ramas: una para el éxito y otra para el fracaso. En cada extremo, se añaden dos ramas (éxito y fracaso) para el siguiente ensayo. Esto se repite hasta que se alcanza el número total de sucesos. En cada extremo final, se puede contar el número de éxitos. Se multiplica el número de veces que k tiene éxito por la probabilidad de que k tenga éxito para obtener la probabilidad correspondiente de la distribución binomial.

Definición

[editar]Notación

[editar]Si una variable aleatoria discreta tiene una distribución binomial con parámetros y con entonces escribiremos .

Función de Probabilidad

[editar]Si entonces su función de probabilidad está dada por

para , siendo

el coeficiente binomial y se lee “las combinaciones de en “.

En ocasiones, para calcular las probabilidades binomiales se utiliza la siguiente fórmula recursiva para calcular en términos de

Función de Distribución Acumulada

[editar]La función de distribución acumulada de una variable aleatoria está dada por

También puede ser expresada en términos de la función beta incompleta como

que es equivalente a la función de distribución acumulada de la distribución F.

La distribución binomial es la base del test binomial de significación estadística.

Experimento binomial

[editar]Existen muchas situaciones en las que se presenta una experiencia binomial. Cada uno de los experimentos es independiente de los restantes (la probabilidad del resultado de un experimento no depende del resultado del resto). El resultado de cada experimento ha de admitir sólo dos categorías (a las que se denomina éxito y fracaso). El valor de ambas posibilidades ha de ser constante en todos los experimentos, y se denotan como y respectivamente o como y de forma alternativa.

Se designa por a la variable que mide el número de éxitos que se han producido en los experimentos.

Cuando se dan estas circunstancias, se dice que la variable sigue una distribución de probabilidad binomial.

Ejemplo

[editar]Supongamos que se lanza 51 veces un dado de 6 caras y queremos calcular la probabilidad de que el número 3 salga 20 veces.

En este problema un ensayo consiste en lanzar el dado una vez. Consideramos un éxito si obtenemos un 3 pero si no sale 3 lo consideramos como un fracaso. Defínase como el número de veces que se obtiene un 3 en 51 lanzamientos.

En este caso tenemos por lo que la probabilidad buscada es

Propiedades

[editar]Si es una variable aleatoria discreta tal que entonces

La primera de ellas es fácil de demostrar, por definición de Esperanza

el primer término de la suma, es decir, para el término vale cero por lo que podemos iniciar la suma en

Dado que

para .

Reemplazando lo anterior en la expresión de obtenemos

Haciendo el cambio de índice obtenemos

Finalmente por la fórmula de Newton (Teorema del binomio)

Obtenemos

- .

Distribuciones Relacionadas

[editar]Suma de Binomiales

[editar]Si y son variables aleatorias independientes con la misma probabilidad entonces la variable aleatoria también es una variable aleatoria con distribución binomial con parámetros y , es decir

Distribución Bernoulli

[editar]Si son variables aleatorias independientes e idénticamente distribuidas tales que entonces

Lo anterior es equivalente a decir que la distribución Bernoulli es un caso particular de la distribución Binomial cuando , es decir, si entonces .

Distribuciones limitantes

[editar]Teorema límite de Poisson

[editar]Si y es tal que el producto entre ambos parámetros tiende a , entonces la distribución de la variable aleatoria binomial tiende a una distribución de Poisson de parámetro .

Teorema de De Moivre-Laplace

[editar]Si es una variable aleatoria con media y varianza entonces

conforme , esta aproximación es buena si y .

Propiedades reproductivas

[editar]Si son variables aleatorias independientes tales que con entonces

Inferencia estadística

[editar]Estimación de parámetros

[editar]Cuando se conoce n, el parámetro p puede estimarse utilizando la proporción de aciertos:

Este estimador se encuentra utilizando estimador de máxima verosimilitud y también el método de los momentos. Este estimador es insesgado y uniforme con mínima varianza, demostrado mediante el Teorema de Lehmann–Scheffé, ya que se basa en un estadístico mínimo suficiente y completo (es decir: x). También es consistente tanto en probabilidad como en MSE.

También existe un estimador de Bayes de forma cerrada para p cuando se utiliza la distribución Beta como conjugada de la probabilidad a priori. Cuando se utiliza un a priori, el estimador medio posterior es:

El estimador de Bayes es asintóticamente eficiente y a medida que el tamaño de la muestra se aproxima a infinito (n → ∞), se aproxima a la solución de máxima verosimilitud. El estimador de Bayes es sesgado, cuánto depende de los priores, admisible y consistente en probabilidad.

Para el caso especial de utilizar la distribución uniforme estándar como a priori no informativo, , el estimador de la media a posteriori se convierte en:

Este método se denomina regla de sucesión, que fue introducido en el siglo XVIII por Pierre-Simon Laplace.

Cuando se estima p con sucesos muy raros y un n pequeño (por ejemplo: si x=0), entonces utilizar el estimador estándar conduce a lo que a veces es poco realista y poco deseable. En estos casos existen varios estimadores alternativos.[5] Una forma es utilizar el estimador de Bayes, lo que lleva a:

Otro método consiste en utilizar el límite superior del intervalo de confianza obtenido mediante la regla de tres:

Intervalos de confianza

[editar]Incluso para valores bastante grandes de n, la distribución real de la media es significativamente no normal.[6] Debido a este problema se han propuesto varios métodos para estimar intervalos de confianza.

En las ecuaciones para intervalos de confianza que se presentan a continuación, las variables tienen el siguiente significado:

- n 1 es el número de aciertos de n, el número total de ensayos.

- es la proporción de aciertos

- es el cuantil de una distribución normal estándar (es decir, probit) correspondiente a la tasa de error objetivo . Por ejemplo, para un nivel de confianza del 95% el error = 0,05, por lo que = 0,975 y = 1,96.

Véase también

[editar]- Distribución Bernoulli

- Distribución Binomial Negativa

- Distribución de Poisson

- Distribución Normal

- Distribución Gamma

- Distribución Beta

Referencias

[editar]- ↑ Hamza, K. (1995). The smallest uniform upper bound on the distance between the mean and the median of the binomial and Poisson distributions. Statist. Probab. Lett. 23 21–25.

- ↑ Wadsworth, G. P. (1960). Introduction to Probability and Random Variables. New York: McGraw-Hill. p. 52.

- ↑ Gossett, 2009, p. 310.

- ↑ Dodge, 2007, p. 175.

- ↑ Razzaghi, Mehdi (2002). «Sobre la estimación de la probabilidad de éxito binomial con ocurrencia cero en la muestra». Journal of Modern Applied Statistical Methods 1 (2): 326-332. doi:10.22237/jmasm/1036110000.

- ↑ Brown, Lawrence D.; Cai, T. Tony; DasGupta, Anirban (2001), html «Estimación de intervalos para una proporción binomial», Statistical Science 16 (2): 101-133, doi:10.1214/ss/1009213286, consultado el 5 de enero de 2015 Parámetro desconocido

|citeseerx=ignorado (ayuda).

Bibliografía

[editar]- Hirsch, Werner Z. (1957). «Binomial Distribution—Success or Failure, How Likely Are They?». Introduction to Modern Statistics. New York: MacMillan. pp. 140-153.

- Neter, John; Wasserman, William; Whitmore, G. A. (1988). Applied Statistics (Third edición). Boston: Allyn & Bacon. pp. 185–192. ISBN 0-205-10328-6.

- Patrick Bogaert (2005). Probabilités pour scientifiques et ingénieurs. De Boeck Supérieur. p. 402. ISBN 2-8041-4794-0.

Enlaces externos

[editar] Wikimedia Commons alberga una categoría multimedia sobre Distribución binomial.

Wikimedia Commons alberga una categoría multimedia sobre Distribución binomial.- Tablas de la distribución binomial, hasta n=20, en formato PDF.

- Calculadora Distribución binomial

- Cálculo de la probabilidad de una distribución binomial con R (lenguaje de programación)

- Generación estadística de la distribución binomial con números aleatorios usando Python (lenguaje de programación)

- Interactive graphic: Univariate Distribution Relationships

- Binomial distribution formula calculator

- Difference of two binomial variables: X-Y or |X-Y|

- Querying the binomial probability distribution in WolframAlpha

![{\displaystyle \operatorname {P} [X=x]={n \choose x}p^{x}(1-p)^{n-x}}](https://wikimedia.org/eswiki/api/rest_v1/media/math/render/svg/da3660ed6436bbf2124b54ccd0c669f7978d7555)

![{\displaystyle \operatorname {P} [X=x+1]}](https://wikimedia.org/eswiki/api/rest_v1/media/math/render/svg/c257ee39ce84d39f7d6e328fb448810c30f269ba)

![{\displaystyle \operatorname {P} [X=x]}](https://wikimedia.org/eswiki/api/rest_v1/media/math/render/svg/ac2c698a2e23688ac8f11e09e070df32addeaa03)

![{\displaystyle {\begin{aligned}\operatorname {P} [X=x+1]&={\binom {n}{x+1}}p^{x+1}(1-p)^{n-(x+1)}\\&={\frac {n!}{(n-x-1)!(x+1)!}}p^{x+1}(1-p)^{n-x-1}\\&={\frac {n!(n-x)}{(n-x)!x!(x+1)}}p^{x}(1-p)^{n-x}{\frac {p}{1-p}}\\&=\left({\frac {n-x}{x+1}}\right)\left({\frac {p}{1-p}}\right){\frac {n!}{x!(n-x)!}}p^{x}(1-p)^{n-x}\\&=\left({\frac {n-x}{x+1}}\right)\left({\frac {p}{1-p}}\right){\binom {n}{x}}p^{x}(1-p)^{n-x}\\&=\left({\frac {n-x}{x+1}}\right)\left({\frac {p}{1-p}}\right)\operatorname {P} [X=x]\end{aligned}}}](https://wikimedia.org/eswiki/api/rest_v1/media/math/render/svg/42c3103828166798ba02a166d5a01255a2c03ab7)

![{\displaystyle F_{X}(x)=\operatorname {P} [X\leq x]=\sum _{k=0}^{x}{n \choose k}p^{k}(1-p)^{n-k}}](https://wikimedia.org/eswiki/api/rest_v1/media/math/render/svg/512a2c64073a9d8568092601577850270f068dbf)

![{\displaystyle {\begin{aligned}F_{X}(x)&=\operatorname {P} [X\leq x]\\&=I_{1-p}(n-x,x+1)\\&=(n-x){n \choose x}\int _{0}^{1-p}t^{n-x-1}(1-t)^{x}dt\end{aligned}}}](https://wikimedia.org/eswiki/api/rest_v1/media/math/render/svg/0ae8855cfd8da0e2c99d2978934d62a4e52ca9c5)

![{\displaystyle \operatorname {P} [X=20]}](https://wikimedia.org/eswiki/api/rest_v1/media/math/render/svg/a6d1b29bfd7fc7cec4e3ba8de64891b87005ff80)

![{\displaystyle \operatorname {P} [X=20]={51 \choose 20}(1/6)^{20}(1-1/6)^{51-20}=0.0000744\,\!}](https://wikimedia.org/eswiki/api/rest_v1/media/math/render/svg/48509f2d00bc9e71b85f19fe4d91a34b6805f3f2)

![{\displaystyle \operatorname {E} [X]=np}](https://wikimedia.org/eswiki/api/rest_v1/media/math/render/svg/8a847aa9a0c1fc2751c00a6b9cb4be55e784e88a)

![{\displaystyle \operatorname {Var} [X]=np(1-p)}](https://wikimedia.org/eswiki/api/rest_v1/media/math/render/svg/23eeb9e25ec727bf979d0432c8175efe6f2e319b)

![{\displaystyle \operatorname {E} [X]=\sum _{x=0}^{n}x{\binom {n}{x}}p^{x}(1-p)^{n-x}\,}](https://wikimedia.org/eswiki/api/rest_v1/media/math/render/svg/2a79b3bbc6629885fa167931449beb2cfef22035)

![{\displaystyle \operatorname {E} [X]=\sum _{x=1}^{n}x{\binom {n}{x}}p^{x}(1-p)^{n-x}\,}](https://wikimedia.org/eswiki/api/rest_v1/media/math/render/svg/32c894cfd35af2616e2d8a81cc88ea21c7b2d2b1)

![{\displaystyle \operatorname {E} [X]}](https://wikimedia.org/eswiki/api/rest_v1/media/math/render/svg/44dd294aa33c0865f58e2b1bdaf44ebe911dbf93)

![{\displaystyle {\begin{aligned}\operatorname {E} [X]&=\sum _{x=1}^{n}x{\frac {n}{x}}{\binom {n-1}{x-1}}p^{x}(1-p)^{n-x}\\&=n\sum _{x=1}^{n}{\binom {n-1}{x-1}}p^{x}(1-p)^{n-x}\end{aligned}}}](https://wikimedia.org/eswiki/api/rest_v1/media/math/render/svg/5bc67bed2a02ae432cc12407cf80f43c94eaffea)

![{\displaystyle {\begin{aligned}\operatorname {E} [X]&=n\sum _{k=0}^{n-1}{\binom {n-1}{k}}p^{k+1}(1-p)^{n-(k+1)}\\&=np\sum _{k=0}^{n-1}{\binom {n-1}{k}}p^{k}(1-p)^{(n-1)-k}\end{aligned}}}](https://wikimedia.org/eswiki/api/rest_v1/media/math/render/svg/f99d72ff5bc2256f230792929d92e2edcb1f09d8)

![{\displaystyle \operatorname {E} [X]=np(p+1-p)^{n-1}=np}](https://wikimedia.org/eswiki/api/rest_v1/media/math/render/svg/2df910e40405784cce9fc4519ea571d358a7dbea)

![{\displaystyle {\begin{aligned}\operatorname {P} [Z=z]&=\sum _{k=0}^{z}{\binom {n}{k}}p^{k}(1-p)^{n-k}{\binom {m}{z-k}}p^{z-k}(1-p)^{m-z+k}\\&={\binom {n+m}{z}}p^{z}(1-p)^{n+m-z}\end{aligned}}}](https://wikimedia.org/eswiki/api/rest_v1/media/math/render/svg/143796a76d8d442132a575efe91988bbea219d07)