Cálculo diferencial

El cálculo diferencial es una parte del cálculo infinitesimal y del análisis matemático que estudia cómo cambian las funciones continuas según sus variables cambian de estado. El principal objeto de estudio en el cálculo diferencial es la derivada.[1] Una noción estrechamente relacionada es la de diferencial de una función.

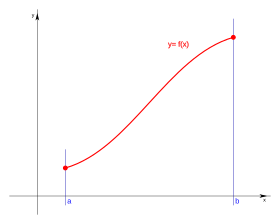

El estudio del cambio de una función es de especial interés para el cálculo diferencial, en concreto el caso en el que el cambio de las variables es infinitesimal, esto es, cuando dicho cambio tiende a cero (se hace tan pequeño como se desee). Y es que el cálculo diferencial se apoya constantemente en el concepto básico del límite. El paso al límite es la principal herramienta que permite desarrollar la teoría del cálculo diferencial y la que lo diferencia claramente del álgebra. Desde el punto de vista filosófico de las funciones y la geometría, la derivada de una función en un cierto punto es una medida de la tasa en la cual una función cambia conforme un argumento se modifica. Esto es, una derivada involucra, en términos matemáticos, una tasa de cambio. Una derivada es el cálculo de las pendientes instantáneas de en cada punto . Esto se corresponde a las pendientes de las tangentes de la gráfica de dicha función en sus puntos (una tangente por punto); Las derivadas pueden ser utilizadas para conocer la concavidad de una función, sus intervalos de crecimiento, sus máximos y mínimos. La inversa de una derivada se llama primitiva, antiderivada o integral.

Diferenciación y diferenciabilidad

Una función de una variable es diferenciable en punto si su derivada existe en ese punto; una función es diferenciable en un intervalo si lo es en cada punto perteneciente al intervalo. Si una función no es continua en c, entonces no puede ser diferenciable en c; sin embargo, aunque una función sea continua en c, puede no ser diferenciable. Es decir, toda función diferenciable en un punto c es continua en c, pero no toda función continua en c es diferenciable en c (como f(x) = |x| es continua, pero no diferenciable en x = 0).

Noción de derivada

Las derivadas se definen tomando el límite de la pendiente de las rectas secantes conforme se van aproximando a la recta tangente. Es difícil hallar directamente la pendiente de la recta tangente de una función porque sólo se conoce un punto de esta, el punto donde ha de ser tangente a la función. Por ello, se aproxima la recta tangente por rectas secantes. Cuando se tome el límite de las pendientes de las secantes próximas, se obtendrá la pendiente de la recta tangente.

Para obtener estas pendientes, tómese un número arbitrariamente pequeño que se denominará h. h representa una pequeña variación en x, y puede ser tanto positivo como negativo. La pendiente de la recta entre los puntos y es

Esta expresión es un cociente diferencial de Newton. La derivada de f en x es el límite del valor del cociente diferencial conforme las líneas secantes se acercan más a la tangente:

Si la derivada de f existe en cada punto x, es posible entonces definir la derivada de f como la función cuyo valor en el punto x es la derivada de f en x.

Puesto que la inmediata sustitución de h por 0 da como resultado una división por cero, calcular la derivada directamente puede ser poco intuitivo. Una técnica consiste en simplificar el numerador de modo que la h del denominador pueda cancelarse. Esto resulta muy sencillo con funciones polinómicas, pero para la mayoría de las funciones resulta demasiado complicado. Afortunadamente, hay reglas generales que facilitan la diferenciación de la mayoría de las funciones.

El cociente diferencial alternativo

La derivada de f(x) (tal como la definió Newton) se describió como el límite, conforme h se aproxima a cero. Una explicación alternativa de la derivada puede interpretarse a partir del cociente de Newton. Si se utiliza la fórmula anterior, la derivada en c es igual al límite conforme h se aproxima a cero de [f(c + h) - f(c)] / h. Si se deja que h = x - c (por ende, c + h = x), entonces x se aproxima a c (conforme h tiende a cero). Así, la derivada es igual al límite conforme x se aproxima a c, de [f(x) - f(c)] / (x - c). Esta definición se utiliza para una demostración parcial de la regla de la cadena.

Funciones de varias variables

Para funciones de varias variables , las condiciones de diferenciabilidad son más estrictas y requieren más condiciones aparte de la existencia de derivadas parciales. En concreto, se requiere la existencia de una aproximación lineal a la función en el entorno de un punto. Dada una base vectorial, esta aproximación lineal viene dada por la matriz jacobiana:

Historia

Los problemas comunes que dieron origen al cálculo infinitesimal comenzaron a plantearse en la época clásica de la antigua Grecia (siglo III a. C..), con conceptos de tipo geométrico como el problema de la tangente a una curva de Apolonio de Perge, pero no se encontraron métodos sistemáticos de resolución sino hasta el siglo XVII, gracias a los trabajos de Isaac Newton y de Gottfried Wilhelm Leibniz.

Ellos dos sintetizaron dos conceptos y métodos usados por sus predecesores en lo que hoy se denomina «diferenciación» e «integración». Desarrollaron reglas para manipular las derivadas (reglas de derivación) y demostraron que ambos conceptos eran inversos (teorema fundamental del cálculo).

Desde el siglo XVII, muchos matemáticos han contribuido al cálculo diferencial. En el siglo XIX, el cálculo tomó un estilo más riguroso, debido a matemáticos como Augustin Louis Cauchy (1789-1857), Bernhard Riemann (1826-1866), y Karl Weierstrass (1815-1897). Fue también durante este periodo cuando el cálculo diferencial se generalizó al espacio euclídeo y al plano complejo.

Aplicaciones importantes del cálculo diferencial

Recta tangente a una función en un punto

La recta tangente a una función es como se ha visto el límite de las rectas secantes cuando uno de los puntos de corte de la secante con la función se hace tender hacia el otro punto de corte. También puede definirse a la recta tangente como la mejor aproximación lineal a la función en su punto de tangencia, esto es, la recta tangente es la función polinómica de primer grado que mejor aproxima a la función localmente en el punto de tangencia considerado.

Si se conoce la ecuación de la recta tangente a la función en el punto , puede tomarse como una aproximación razonablemente buena de en las proximidades del punto . Esto quiere decir que, si se toma un punto y se evalúa tanto en la función como en la recta tangente, la diferencia será despreciable frente a en valor absoluto si tiende a cero. Cuanto más cerca se esté del punto tanto más precisa será la aproximación de .

Para una función derivable localmente en el punto , la recta tangente a por el punto a es:

Uso de las derivadas para realizar gráficos de funciones

Las derivadas son una herramienta útil para examinar las gráficas de funciones. En particular, los puntos en el interior de un dominio de una función de valores reales que llevan a dicha función a un extremo local tendrán una primera derivada de cero. Sin embargo, no todos los puntos críticos son extremos locales. Por ejemplo, f(x)=x³ tiene un punto crítico en x=0, pero en ese punto no hay un máximo ni un mínimo. El criterio de la primera derivada y el criterio de la segunda derivada permiten determinar si los puntos críticos son máximos, mínimos o ninguno.

En el caso de dominios multidimensionales, la función tendrá una derivada parcial de cero con respecto a cada dimensión en un extremo local. En este caso, la prueba de la segunda derivada se puede seguir utilizando para caracterizar a los puntos críticos, considerando el eigenvalor de la matriz Hessiana de las segundas derivadas parciales de la función en el punto crítico. Si todos los eigenvalores son positivos, entonces el punto es un mínimo local; si todos son negativos, entonces es un máximo local. Si hay algunos eigenvalores positivos y algunos negativos, entonces el punto crítico es un punto silla, y si no se cumple ninguno de estos casos, la prueba es no concluyente (es decir, los engeivalores son 0 y 3).

Una vez que se encuentran los extremos locales, es mucho más fácil hacerse de una burda idea de la gráfica general de la función, ya que (en el caso del dominio monodimensional) se incrementará o decrementará uniformemente excepto en los puntos críticos, y por ello (suponiendo su continuidad) tendrá valores intermedios entre los valores en los puntos críticos de cada lado.

Aproximación local de Taylor

Es posible entonces aproximar mediante su recta tangente a una función derivable localmente en un punto. Si se cumple que la función es suficientemente suave en el punto o dominio de estudio (esto es, la función es de clase ), entonces se puede aproximar la función no por polinomios de grado uno, sino de grado dos, tres, cuatro y sucesivamente. Esta aproximación recibe el nombre de «desarrollo polinómico de Taylor» y se define de la siguiente manera:

Donde es el polinomio de grado que mejor aproxima a la función en el punto . Nótese que, si se evalúa en , todos los términos salvo el primero se anulan; luego, . Nótese también que la ecuación de la recta tangente del apartado anterior corresponde al caso en el que .

Cuando , el desarrollo se denomina desarrollo de MacLaurin. En la práctica, la mayoría de las veces se emplean desarrollos de MacLaurin. Ejemplos de desarrollos importantes de MacLaurin son:

Nótese el símbolo que denota aproximación, no igualdad. Si la función a aproximar es infinitamente derivable () y se agregan infinitos términos al desarrollo, entonces el se convierte en un y el desarrollo anterior se convierte en una serie de Taylor. Las funciones que son igual a su serie de Taylor se denominan funciones analíticas.

Cálculo de puntos

Dada una función

podemos diferenciar los siguientes puntos:[2]

Puntos críticos

Por punto crítico se entiende por un punto singular o estacionario.

Puntos singulares

Son puntos singulares los valores en los que la derivada de la función: , presenta algún tipo de discontinuidad.i

Puntos estacionarios

Se denomina punto estacionario a los valores de la variable en los que se anula la derivada , es decir, si para entonces son puntos estacionarios de .

Los valores , se llaman valores estacionarios.

Si la segunda derivada es positiva en un punto estacionarios, se dice que el punto es un mínimo local; si es negativa, se dice que el punto es un máximo local; si vale cero, puede ser tanto un mínimo como un máximo o un punto de inflexión. Derivar y resolver en los puntos críticos suele ser una forma simple de encontrar máximos y mínimos locales, que pueden emplearse en optimización. No obstante, nunca hay que despreciar los extremos en dichos problemas.

Generalización del cálculo diferencial

Cuando una función depende de más de una variable, se utiliza el concepto de derivada parcial. Las derivadas parciales se pueden pensar informalmente como tomar la derivada de una función con respecto a una de ellas, manteniendo las demás variables constantes. Las derivadas parciales se representan como:

En donde es una 'd' redondeada conocida como 'símbolo de la derivada parcial'.

El concepto de derivada puede extenderse de forma más general. El hilo común es que la derivada en un punto sirve como una aproximación lineal a la función en dicho punto. Quizá la situación más natural es que las funciones sean diferenciables en las variedades. La derivada en un cierto punto entonces se convierte en una transformación lineal entre los correspondientes espacios tangentes, y la derivada de la función se convierte en un mapeo entre los grupos tangentes.

Para diferenciar todas las funciones continuas y mucho más, se puede definir el concepto de distribución. Para las funciones complejas de una variable compleja, la diferenciabilidad es una condición mucho más fuerte que la simple parte real e imaginaria de la función diferenciada con respecto a la parte real e imaginaria del argumento. Por ejemplo, la función satisface lo segundo, pero no lo primero. Véase también la función holomórfica.

Véase también: diferintegral.

Dadas las funciones, de valor real, y ambas con dominio, el problema consiste en hallar los valores máximos o mínimos (valores extremos) de cuando se restringe a tomar valores en el conjunto.

Conjunto de Operadores Fraccionales

El cálculo fraccional de conjuntos (Fractional Calculus of Sets (FCS)), mencionado por primera vez en el artículo titulado "Sets of Fractional Operators and Numerical Estimation of the Order of Convergence of a Family of Fractional Fixed-Point Methods",[3] es una metodología derivada del cálculo fraccional.[4] El concepto principal detrás del FCS es la caracterización de los elementos del cálculo fraccional utilizando conjuntos debido a la gran cantidad de operadores fraccionales disponibles.[5][6][7] Esta metodología se originó a partir del desarrollo del método de Newton-Raphson fraccional [8] y trabajos relacionados posteriores.[9][10][11]

El cálculo fraccional, una rama de las matemáticas que trata con derivadas de orden no entero, surgió casi simultáneamente con el cálculo tradicional. Esta emergencia fue en parte debido a la notación de Leibniz para derivadas de orden entero: . Gracias a esta notación, L’Hopital pudo preguntar en una carta a Leibniz sobre la interpretación de tomar en una derivada. En ese momento, Leibniz no pudo proporcionar una interpretación física o geométrica para esta pregunta, por lo que simplemente respondió a L’Hopital en una carta que "... es una aparente paradoja de la cual, algún día, se derivarán consecuencias útiles".

El nombre "cálculo fraccional" se origina a partir de una pregunta histórica, ya que esta rama del análisis matemático estudia derivadas e integrales de un cierto orden . Actualmente, el cálculo fraccional carece de una definición unificada de lo que constituye una derivada fraccional. En consecuencia, cuando no es necesario especificar explícitamente la forma de una derivada fraccional, típicamente se denota de la siguiente manera:

Los operadores fraccionales tienen varias representaciones, pero una de sus propiedades fundamentales es que recuperan los resultados del cálculo tradicional a medida que . Considerando una función escalar y la base canónica de denotada por , el siguiente operador fraccional de orden se define utilizando notación de Einstein:[12]

Denotando como la derivada parcial de orden con respecto al componente -ésimo del vector , se define el siguiente conjunto de operadores fraccionales [13] [14]:

cuyo complemento es:

Como consecuencia, se define el siguiente conjunto:

Extensión a Funciones Vectoriales

Para una función , el conjunto se define como:

donde denota el -ésimo componente de la función .

Véase también

Referencias

- ↑ ¿Qué es el cálculo?, consultado el 18 de septiembre de 2021.

- ↑ Diccionario de ciencias (1 edición). Editorial Complutense. 2000. p. 564. ISBN 84-89784-80-9.

- ↑ Sets of Fractional Operators and Numerical Estimation of the Order of Convergence of a Family of Fractional Fixed-Point Methods

- ↑ Applications of fractional calculus in physics

- ↑ A review of definitions for fractional derivatives and integral

- ↑ A review of definitions of fractional derivatives and other operators

- ↑ How many fractional derivatives are there?

- ↑ Fractional Newton-Raphson Method

- ↑ Acceleration of the order of convergence of a family of fractional fixed-point methods and its implementation in the solution of a nonlinear algebraic system related to hybrid solar receivers

- ↑ Code of a multidimensional fractional quasi-Newton method with an order of convergence at least quadratic using recursive programming

- ↑ Sets of Fractional Operators and Some of Their Applications

- ↑ Einstein summation for multidimensional arrays

- ↑ Torres-Hernandez, A.; Brambila-Paz, F. (29 de diciembre de 2021). «Sets of Fractional Operators and Numerical Estimation of the Order of Convergence of a Family of Fractional Fixed-Point Methods». Fractal and Fractional 5 (4): 240. doi:10.3390/fractalfract5040240.

- ↑ Acceleration of the order of convergence of a family of fractional fixed-point methods and its implementation in the solution of a nonlinear algebraic system related to hybrid solar receivers

- Calculus of a Single Variable: Early Transcendental Functions (3a edición) por Bruce H Edwards, Robert P. Hostetler y Ron Larson (2003).

- Calculus (2a edición) por Michael Spivak.

- Calculus Early Trascendentals (6a edición) por James Stewart.

- Principios de Análisis Matemático por Enrique Linés Escardo.

Enlaces externos

Wikiversidad alberga proyectos de aprendizaje sobre Cálculo diferencial.

Wikiversidad alberga proyectos de aprendizaje sobre Cálculo diferencial. Wikilibros alberga un libro o manual sobre cálculo diferencial.

Wikilibros alberga un libro o manual sobre cálculo diferencial.- Libro de cálculo diferencial e integral (bajo licencia libre Creative Commons)

- WIMS Calculador de funciones hace el cálculo de derivadas en línea

- Cálculo Diferencial e Integral en una Variable (enlace roto disponible en Internet Archive; véase el historial, la primera versión y la última). (libro gratuito)

Videotutoriales

- Derivación con límites Archivado el 10 de enero de 2012 en Wayback Machine.

- Ecuación de la recta tangente en un punto dado Archivado el 10 de enero de 2012 en Wayback Machine.

- Derivadas con fórmulas Archivado el 10 de enero de 2012 en Wayback Machine.

- Aplicaciones de la derivada Archivado el 9 de enero de 2012 en Wayback Machine.

![{\displaystyle {\begin{aligned}f:[a,b]&\to \mathbb {R} \\x&\mapsto f(x)\end{aligned}}}](https://wikimedia.org/eswiki/api/rest_v1/media/math/render/svg/72c163f3e1380aa737c549a68b7e629fe45e701b)

![{\displaystyle {}_{m}O_{x,\alpha }^{n,u}(h):=\left\{o_{x}^{\alpha }:o_{x}^{\alpha }\in O_{x,\alpha }^{n,u}([h]_{k})\ \forall k\leq m\right\},}](https://wikimedia.org/eswiki/api/rest_v1/media/math/render/svg/561447b93ec74bfb991befdb5c3f8d3992d16eef)

![{\displaystyle [h]_{k}:\Omega \subset \mathbb {R} ^{m}\to \mathbb {R} }](https://wikimedia.org/eswiki/api/rest_v1/media/math/render/svg/ee783a914e481d39869a85042185b842d6cab1c7)