Вероятность: различия между версиями

| [отпатрулированная версия] | [отпатрулированная версия] |

м откат правок 89.223.104.202 (обс.) к версии Roxiffe-le-boim Метка: откат |

EyeBot (обсуждение | вклад) м автоматическая отмена правки участника 77.34.182.189 - R:4B ORES: 0.8286 Метка: откат |

||

| (не показано 30 промежуточных версий 17 участников) | |||

| Строка 15: | Строка 15: | ||

=== Предыстория понятия вероятности === |

=== Предыстория понятия вероятности === |

||

Необходимость понятия вероятности и исследований в этом направлении была исторически связана с [[Азартная игра|азартными играми]], особенно с играми в кости. До появления понятия вероятности формулировались в основном [[Комбинаторика|комбинаторные задачи]] подсчёта числа возможных исходов при бросании нескольких костей, а также задача раздела ставки между игроками, когда игра закончена досрочно. Первую задачу при бросании трёх костей «решил» в 960 году епископ [[Виболд]] из г. [[Камбре]]<ref name="Gnedenko">Гнеденко Б. В. Курс теории вероятностей: Учебник — Изд. 6-е, перераб. и доп. — М.: Наука. Гл. ред. физ. мат. лит., 1988 — 448с.- с.386-387</ref>. Он насчитал 56 вариантов. Однако это количество по сути не отражает количество равновероятных возможностей, поскольку каждый из 56 вариантов может реализоваться разным количеством способов. В первой половине XIII века эти аспекты учёл [[Ришар де Форниваль]]. Несмотря на то, что у него тоже фигурирует число 56, |

Необходимость понятия вероятности и исследований в этом направлении была исторически связана с [[Азартная игра|азартными играми]], особенно с играми в кости. До появления понятия вероятности формулировались в основном [[Комбинаторика|комбинаторные задачи]] подсчёта числа возможных исходов при бросании нескольких костей, а также задача раздела ставки между игроками, когда игра закончена досрочно. Первую задачу при бросании трёх костей «решил» в 960 году епископ [[Виболд]] из г. [[Камбре]]<ref name="Gnedenko">Гнеденко Б. В. Курс теории вероятностей: Учебник — Изд. 6-е, перераб. и доп. — М.: Наука. Гл. ред. физ. мат. лит., 1988 — 448с.- с.386-387</ref>. Он насчитал 56 вариантов. Однако это количество, по сути, не отражает количество равновероятных возможностей, поскольку каждый из 56 вариантов может реализоваться разным количеством способов. В первой половине XIII века эти аспекты учёл [[Ришар де Форниваль]]. Несмотря на то, что у него тоже фигурирует число 56, в рассуждениях он отмечает, что «одинаковое количество очков на трёх костях можно получить шестью способами». Основываясь на его рассуждениях, можно установить, что число равновозможных вариантов — 216. В дальнейшем многие не совсем верно решали эту задачу. Впервые точное количество равновозможных исходов при подбрасывании трёх костей подсчитал [[Галилей, Галилео|Галилео Галилей]], возводя шестёрку (количество вариантов выпадения одной кости) в степень 3 (количество костей): 6³=216. Он же составил таблицы количества способов получения различных сумм очков. |

||

В конце XV века [[Пачоли, Лука|Лука Пачоли]]<ref name="Gnedenko"/> сформулировал задачи второго типа и предложил первое решение (которое было ошибочным). Его решение заключалось в делении ставки пропорционально выигранным партиям. В начале XVI века продвижение исследований в области формулирования комбинаторных задач подсчёта числа возможных исходов при бросании костей связано с именами итальянских учёных [[Кардано, Джероламо|Джероламо Кардано]] и [[Тарталья, Никколо|Н. Тарталья]]. Кардано дал правильный подсчёт количества случаев при бросании двух костей (36). Он также впервые соотнёс количество случаев выпадения некоторого числа хотя бы на одной кости (11) к общему числу исходов (что соответствует классическому определению вероятности) — 11/36. Аналогично и для трёх костей он рассматривал, например, что девять очков может получиться количеством способов, равным 1/9 «всей серии» (то есть общего количества равновозможных исходов — 216). Кардано формально не вводил понятие вероятности, но по существу рассматривал относительное количество исходов, что по сути эквивалентно рассмотрению вероятностей. Также в его работах можно найти идеи, связанные с законом больших чисел. По поводу задачи деления ставки Кардано предлагал учитывать количество оставшихся партий, которые надо выиграть. Н. Тарталья также делал замечания по поводу решения Луки и предложил своё решение, тоже ошибочное. |

|||

Заслуга Галилея также заключается в расширении |

Заслуга Галилея также заключается в расширении круга исследований на область ошибок наблюдений. Он впервые указал на неизбежность ошибок и классифицировал их на систематические и случайные (такая классификация применяется и сейчас). |

||

[[Файл:Bendixen - Carl Friedrich Gauß, 1828.jpg|thumb|140px|[[Гаусс, Карл Фридрих|Карл Фридрих Гаусс]]]] |

[[Файл:Bendixen - Carl Friedrich Gauß, 1828.jpg|thumb|140px|[[Гаусс, Карл Фридрих|Карл Фридрих Гаусс]]]] |

||

=== Возникновение понятия и теории вероятностей === |

=== Возникновение понятия и теории вероятностей === |

||

К первым работам, посвящённым понятию вероятности, можно отнести переписку французских учёных [[Паскаль, Блез|Б. Паскаля]], [[Ферма, Пьер|П. Ферма]] (1654 год) и нидерландского учёного [[Гюйгенс, Христиан|X. Гюйгенса]] (1657 год), давшего самую раннюю из известных научных трактовок вероятности<ref>{{citation|url=http://www.secondmoment.org/articles/probability.php|publisher=Second Moment|accessdate=2017-11-10|title=A Brief History of Probability|last=Abrams|first=William|url-status=dead|archiveurl=https://web.archive.org/web/20160422184852/http://www.secondmoment.org/articles/probability.php|archivedate=2016-04-22}} {{Cite web |url=http://www.secondmoment.org/articles/probability.php |title=Источник |access-date=2013-05-02 |archive-date=2017-07-24 |archive-url=https://web.archive.org/web/20170724052656/http://www.secondmoment.org/articles/probability.php |url-status=dead }}</ref>. По существу, Гюйгенс уже оперировал понятием математического ожидания. В конце XVII века швейцарский математик Я. Бернулли установил закон больших чисел для схемы независимых испытаний с двумя исходами (результат был опубликован в 1713 году, уже после его смерти). |

|||

В XVIII в. — начале XIX в. теория вероятностей получает развитие в работах [[Локальная теорема Муавра — Лапласа|А. Муавра]] (Англия, 1718 год), [[Лаплас, Пьер-Симон|П. Лаплас]] (Франция), [[Гаусс, Карл Фридрих|К. Гаусса]] (Германия) и [[Пуассон, Симеон Дени|С. Пуассона]] (Франция). Теория вероятностей начинает применяться в теории ошибок наблюдений, развившейся в связи с потребностями геодезии и астрономии, и в теории стрельбы. |

В XVIII в. — начале XIX в. теория вероятностей получает развитие в работах [[Локальная теорема Муавра — Лапласа|А. Муавра]] (Англия, 1718 год), [[Лаплас, Пьер-Симон|П. Лаплас]] (Франция), [[Гаусс, Карл Фридрих|К. Гаусса]] (Германия) и [[Пуассон, Симеон Дени|С. Пуассона]] (Франция). Теория вероятностей начинает применяться в теории ошибок наблюдений, развившейся в связи с потребностями геодезии и астрономии, и в теории стрельбы. Лаплас предложил закон распределения ошибок сначала как экспоненциальную зависимость от ошибки без учёта знака (в 1774 году), затем как экспоненциальную функцию квадрата ошибки (в 1778 году). Последний закон обычно называют распределением Гаусса или нормальным распределением. |

||

[[Бернулли, Даниил|Бернулли]] (1778 год) ввёл принцип произведения вероятностей одновременных событий. [[Лежандр, Адриен Мари|Адриен Мари Лежандр]] (1805) разработал [[метод наименьших квадратов]]. |

[[Бернулли, Даниил|Бернулли]] (1778 год) ввёл принцип произведения вероятностей одновременных событий. [[Лежандр, Адриен Мари|Адриен Мари Лежандр]] (1805) разработал [[метод наименьших квадратов]]. |

||

[[Файл:Andrej Nikolajewitsch Kolmogorov.jpg|thumb|left|Андрей Николаевич Колмогоров]] |

[[Файл:Andrej Nikolajewitsch Kolmogorov.jpg|thumb|left|Андрей Николаевич Колмогоров]] |

||

| Строка 47: | Строка 47: | ||

=== Геометрическое определение === |

=== Геометрическое определение === |

||

Несмотря на то, что классическое определение является интуитивно понятным и выведенным из практики, оно, как минимум, не может быть непосредственно применено в случае, если количество равновозможных исходов бесконечно. Ярким примером бесконечного числа возможных исходов является ограниченная геометрическая область G, например, на плоскости |

Несмотря на то, что классическое определение является интуитивно понятным и выведенным из практики, оно, как минимум, не может быть непосредственно применено в случае, если количество равновозможных исходов бесконечно. Ярким примером бесконечного числа возможных исходов является ограниченная геометрическая область G, например, на плоскости с площадью S. Случайно «подброшенная точка» с равной вероятностью может оказаться в любой точке этой области. Задача заключается в определении вероятности попадания точки в некоторую подобласть g с площадью s. В таком случае, обобщая классическое определение, можно прийти к геометрическому определению вероятности попадания в подобласть <math>g</math>: |

||

: <math>\Pr(A)=\frac {s}{S}</math> |

: <math>\Pr(A)=\frac {s}{S}</math> |

||

В виду равновозможности |

В виду равновозможности эта вероятность не зависит от формы области g, она зависит только от её площади. Данное определение естественно можно обобщить и на пространство любой размерности, где вместо площади использовать понятие «объёма». Более того, именно такое определение приводит к современному аксиоматическому определению вероятности. Понятие объёма обобщается до понятия [[Мера множества|меры]] некоторого абстрактного множества, к которой предъявляются требования, которыми обладает и «объём» в геометрической интерпретации — в первую очередь, это неотрицательность и [[Аддитивность (математика)|аддитивность]]. |

||

=== Частотное (статистическое) определение === |

=== Частотное (статистическое) определение === |

||

{{main|Частотная вероятность}} |

{{main|Частотная вероятность}} |

||

Классическое определение при рассмотрении сложных проблем наталкивается на трудности непреодолимого характера. В |

Классическое определение при рассмотрении сложных проблем наталкивается на трудности непреодолимого характера. В некоторых случаях выявить равновозможные случаи может быть невозможно. Даже в случае с монеткой, как известно, существует явно не равновероятная возможность выпадения «ребра», которую из теоретических соображений оценить невозможно (можно только сказать, что оно маловероятно и это соображение скорее практическое). Поэтому ещё на заре становления теории вероятностей было предложено альтернативное «частотное» определение вероятности. А именно, формально вероятность можно определить как предел частоты наблюдений события A, предполагая однородность наблюдений (то есть одинаковость всех условий наблюдения) и их независимость друг от друга: |

||

<math>\Pr(A)=\lim_{N \rightarrow \infty} \frac {n}{N},</math> |

<math>\Pr(A)=\lim_{N \rightarrow \infty} \frac {n}{N},</math> |

||

| Строка 70: | Строка 70: | ||

Во второй половине XX века [[Реньи, Альфред|Альфред Реньи]] и А. Н. Колмогоров исследовали возможность дать обоснование теории вероятностей на базе [[Теория информации|теории информации]]{{sfn |Гнеденко Б. В.|2005|с=407—408 }}. В наши дни «сложилось чёткое понимание того, что теория вероятностей является подлинно математической наукой, имеющей вместе с тем самые тесные и непосредственные связи с широким спектром наук о природе, а также с техническими и социально-экономическими дисциплинами»{{sfn |Математика XIX века. Том I|1978|с=240 }}. |

Во второй половине XX века [[Реньи, Альфред|Альфред Реньи]] и А. Н. Колмогоров исследовали возможность дать обоснование теории вероятностей на базе [[Теория информации|теории информации]]{{sfn |Гнеденко Б. В.|2005|с=407—408 }}. В наши дни «сложилось чёткое понимание того, что теория вероятностей является подлинно математической наукой, имеющей вместе с тем самые тесные и непосредственные связи с широким спектром наук о природе, а также с техническими и социально-экономическими дисциплинами»{{sfn |Математика XIX века. Том I|1978|с=240 }}. |

||

Несмотря на доказанную практикой эффективность вероятностных методов, роль случайности в природе, причина и границы статистической устойчивости остаются предметом дискуссий<ref>{{статья |автор=Алимов Ю. И., Кравцов Ю. А. |заглавие=Является ли вероятность «нормальной» физической величиной? |ссылка=http://ufn.ru/ru/articles/1992/7/d/ |издание=Успехи физических наук |место=М. |год=1992 |номер=162 (7) |страницы=149—182 |archivedate=2020-10-20 |archiveurl=https://web.archive.org/web/20201020122359/https://ufn.ru/ru/articles/1992/7/d/ }}</ref>. «За 200 лет, прошедших со |

Несмотря на доказанную практикой эффективность вероятностных методов, роль случайности в природе, причина и границы статистической устойчивости остаются предметом дискуссий<ref>{{статья |автор=Алимов Ю. И., Кравцов Ю. А. |заглавие=Является ли вероятность «нормальной» физической величиной? |ссылка=http://ufn.ru/ru/articles/1992/7/d/ |издание=Успехи физических наук |место=М. |год=1992 |номер=162 (7) |страницы=149—182 |archivedate=2020-10-20 |archiveurl=https://web.archive.org/web/20201020122359/https://ufn.ru/ru/articles/1992/7/d/ }}</ref>. «За 200 лет, прошедших со времён Лапласа и Гаусса, наука не добилась продвижения в фундаментальном вопросе — когда возникает статистическая устойчивость»<ref>{{статья |автор=Тутубалин В. Н. |заглавие=Вероятность, компьютеры и обработка результатов эксперимента |ссылка=http://ufn.ru/ru/articles/1993/7/g/ |издание=Успехи физических наук |место=М. |год=1993 |номер=163 (7) |страницы=93—109 |archivedate=2021-01-21 |archiveurl=https://web.archive.org/web/20210121214140/https://ufn.ru/ru/articles/1993/7/g/ }}</ref>. |

||

=== Аксиоматическое определение === |

=== Аксиоматическое определение === |

||

| Строка 90: | Строка 90: | ||

'''1)''' вероятность невозможного события (пустого множества <math>\varnothing</math>) равна нулю: |

'''1)''' вероятность невозможного события (пустого множества <math>\varnothing</math>) равна нулю: |

||

: <math>\mathbf{P}\{\varnothing\} = 0.</math> |

|||

Это следует из того, что каждое событие можно представить как сумму этого события и невозможного события, что в силу аддитивности и конечности вероятностной меры означает, что вероятность невозможного события должна быть равна нулю. |

Это следует из того, что каждое событие можно представить как сумму этого события и невозможного события, что в силу аддитивности и конечности вероятностной меры означает, что вероятность невозможного события должна быть равна нулю. |

||

'''2)''' если событие A включается («входит») в событие B, то есть <math>A \subset B</math>, то есть наступление события A влечёт также наступление события B, то |

'''2)''' если событие ''A'' включается («входит») в событие ''B'', то есть <math>A \subset B</math>, то есть наступление события ''A'' влечёт также наступление события ''B'', то |

||

: <math>\mathbf{P}\{A\} \leqslant \mathbf{P}\{B\}.</math> |

|||

Это следует из неотрицательности и аддитивности вероятностной меры, так как событие <math>B</math>, возможно, «содержит» кроме события <math>A</math> ещё какие-то другие события, несовместные с <math>A</math>. |

Это следует из неотрицательности и аддитивности вероятностной меры, так как событие <math>B</math>, возможно, «содержит» кроме события <math>A</math> ещё какие-то другие события, несовместные с <math>A</math>. |

||

'''3)''' вероятность каждого события <math>A</math> находится от 0 до 1, то есть удовлетворяет неравенствам |

'''3)''' вероятность каждого события <math>A</math> находится от 0 до 1, то есть удовлетворяет неравенствам |

||

: <math>0 \leqslant \mathbf{P}\{A\} \leqslant 1.</math> |

|||

Первая часть неравенства (неотрицательность) утверждается аксиоматически, а вторая следует из предыдущего свойства с учётом того, что любое событие «входит» в <math>X</math>, а для <math>X</math> аксиоматически предполагается <math>\mathbf{P}\{X\}=1</math> |

Первая часть неравенства (неотрицательность) утверждается аксиоматически, а вторая следует из предыдущего свойства с учётом того, что любое событие «входит» в <math>X</math>, а для <math>X</math> аксиоматически предполагается <math>\mathbf{P}\{X\} = 1.</math> |

||

'''4)''' вероятность наступления события <math>B\setminus A</math>, где <math>A \subset B</math>, заключающегося в наступлении события <math>B</math> при одновременном ''ненаступлении'' события <math>A</math>, равна |

'''4)''' вероятность наступления события <math>B \setminus A</math>, где <math>A \subset B</math>, заключающегося в наступлении события <math>B</math> при одновременном ''ненаступлении'' события <math>A</math>, равна |

||

: <math>\mathbf{P}\{B \setminus A\} = \mathbf{P}\{B\} - \mathbf{P}\{A\}.</math> |

|||

Это следует из аддитивности вероятности для несовместных событий и из того, что события <math>A</math> и <math>B \setminus A</math> являются несовместными по условию, а их сумма равна событию <math>B</math>. |

Это следует из аддитивности вероятности для несовместных событий и из того, что события <math>A</math> и <math>B \setminus A</math> являются несовместными по условию, а их сумма равна событию <math>B</math>. |

||

'''5)''' вероятность события <math>\bar{A}</math>, противоположного событию <math>A</math>, равна |

'''5)''' вероятность события <math>\bar{A}</math>, противоположного событию <math>A</math>, равна |

||

: <math>\mathbf{P}\{\bar{A}\} = 1 - \mathbf{P}\{A\}.</math> |

|||

Это следует из предыдущего свойства, если в качестве множества <math>B</math> использовать всё пространство <math>X</math> и учесть, что <math>\mathbf{P}\{X\}=1</math> |

Это следует из предыдущего свойства, если в качестве множества <math>B</math> использовать всё пространство <math>X</math> и учесть, что <math>\mathbf{P}\{X\} = 1.</math> |

||

'''6)''' ('''теорема сложения вероятностей''') вероятность наступления хотя бы одного из (то есть суммы) произвольных (не обязательно несовместных) двух событий <math>A</math> и <math>B</math> равна |

'''6)''' ('''теорема сложения вероятностей''') вероятность наступления хотя бы одного из (то есть суммы) произвольных (не обязательно несовместных) двух событий <math>A</math> и <math>B</math> равна |

||

: <math>\mathbf{P}\{A + B\} = \mathbf{P}\{A\} + \mathbf{P}\{B\} - \mathbf{P}\{AB\}.</math> |

|||

Это свойство можно получить, если представить объединение двух произвольных множеств как объединение двух непересекающихся — первого и разности между вторым и пересечением исходных множеств: <math>A + B=A +(B \setminus (A B))</math>. Отсюда учитывая аддитивность вероятности для непересекающихся множеств и формулу для вероятности разности (см. |

Это свойство можно получить, если представить объединение двух произвольных множеств как объединение двух непересекающихся — первого и разности между вторым и пересечением исходных множеств: <math>A + B = A +\big(B \setminus (A B)\big)</math>. Отсюда, учитывая аддитивность вероятности для непересекающихся множеств и формулу для вероятности разности (см. свойство 4) множеств, получаем требуемое свойство. |

||

== Условная вероятность == |

== Условная вероятность == |

||

| Строка 165: | Строка 165: | ||

== Вероятность и случайные величины == |

== Вероятность и случайные величины == |

||

Важнейший частный случай применения «вероятности» — вероятность получения в результате испытания или наблюдения того или иного числового значения некоторой измеряемой (наблюдаемой) величины. Предполагается, что до проведения испытания (наблюдения) точное значение этой величины неизвестно, то есть имеется явная неопределённость, связанная обычно (за исключением квантовой физики) с невозможностью учёта всех факторов, влияющих на результат. Такие величины называют ''[[случайная величина|случайными]]''. В современной теории вероятностей понятие случайной величины формализуется и она определяется как функция «случая» — функция на пространстве элементарных событий. При таком определении наблюдаются не сами элементарные события, а «реализации», конкретные значения случайной величины. Например, при подбрасывании монетки выпадает «решка» или « |

Важнейший частный случай применения «вероятности» — вероятность получения в результате испытания или наблюдения того или иного числового значения некоторой измеряемой (наблюдаемой) величины. Предполагается, что до проведения испытания (наблюдения) точное значение этой величины неизвестно, то есть имеется явная неопределённость, связанная обычно (за исключением квантовой физики) с невозможностью учёта всех факторов, влияющих на результат. Такие величины называют ''[[случайная величина|случайными]]''. В современной теории вероятностей понятие случайной величины формализуется и она определяется как функция «случая» — функция на пространстве элементарных событий. При таком определении наблюдаются не сами элементарные события, а «реализации», конкретные значения случайной величины. Например, при подбрасывании монетки выпадает «решка» или «орёл». Если ввести функцию, ставящую в соответствие «решке» — число 1, а «орлу» — 0, то получим случайную величину как функцию указанных исходов. При этом понятие случайной величины обобщается на функции, отображающие пространство элементарных событий в некоторое пространство произвольной природы, соответственно можно ввести понятия [[случайный вектор|случайного вектора]], [[случайное множество|случайного множества]] и т. д. Однако, обычно под случайной величиной подразумевают именно числовую функцию (величину). |

||

Отвлекаясь от описанной формализации под пространством элементарных событий можно понимать множество возможных значений случайной величины. Сигма-алгеброй подмножеств являются произвольные интервалы на числовой оси, их всевозможные (счётные) объединения и пересечения. Вероятностную меру называют в данном случае ''распределением'' случайной величины. Достаточно задать вероятностную меру для интервалов вида <math>(-\infty;x)</math>, поскольку произвольный интервал можно представить как объединение или пересечение таких интервалов. Предполагается, что каждому интервалу вышеуказаного вида поставлена в соответствие некоторая вероятность <math>F(x)=P(X<x)</math>, то есть некоторая функция возможных значений <math>x</math>. Такую функцию называют ''интегральной, кумулятивной'' или просто ''[[функция распределения|функцией распределения]]'' случайной величины. В случае [[дифференцируемость|дифференцируемости]] этой функции (в этом случае соответствующие случайные величины называются ''[[непрерывная случайная величина|непрерывными]]'') вводится также аналитически часто более удобная функция — ''[[плотность вероятности|плотность распределения]]'' — производная функции распределения: <math>f(x)=F'(x)</math>. В случае ''дискретных случайных величин'' вместо плотности (она не существует в этом случае) можно использовать непосредственно ряд распределения <math>p_i</math> — вероятность <math>i</math>-го значения. Соответствующая функция распределения будет связана с рядом распределения как: <math>F(x)=\sum_{x_i<x} p_i</math>. Вероятность того, что случайная величина окажется в некотором интервале <math>(x_1,x_2)</math> определяется как разность значений функции распределения на концах этого интервала. Через плотность распределения — это соответствующий интеграл от плотности на данном интервале (для дискретной случайной величины — просто сумма вероятностей значений из этого интервала). |

Отвлекаясь от описанной формализации под пространством элементарных событий можно понимать множество возможных значений случайной величины. Сигма-алгеброй подмножеств являются произвольные интервалы на числовой оси, их всевозможные (счётные) объединения и пересечения. Вероятностную меру называют в данном случае ''распределением'' случайной величины. Достаточно задать вероятностную меру для интервалов вида <math>(-\infty;x)</math>, поскольку произвольный интервал можно представить как объединение или пересечение таких интервалов. Предполагается, что каждому интервалу вышеуказаного вида поставлена в соответствие некоторая вероятность <math>F(x)=P(X<x)</math>, то есть некоторая функция возможных значений <math>x</math>. Такую функцию называют ''интегральной, кумулятивной'' или просто ''[[функция распределения|функцией распределения]]'' случайной величины. В случае [[дифференцируемость|дифференцируемости]] этой функции (в этом случае соответствующие случайные величины называются ''[[непрерывная случайная величина|непрерывными]]'') вводится также аналитически часто более удобная функция — ''[[плотность вероятности|плотность распределения]]'' — производная функции распределения: <math>f(x)=F'(x)</math>. В случае ''дискретных случайных величин'' вместо плотности (она не существует в этом случае) можно использовать непосредственно ряд распределения <math>p_i</math> — вероятность <math>i</math>-го значения. Соответствующая функция распределения будет связана с рядом распределения как: <math>F(x)=\sum_{x_i<x} p_i</math>. Вероятность того, что случайная величина окажется в некотором интервале <math>(x_1,x_2)</math> определяется как разность значений функции распределения на концах этого интервала. Через плотность распределения — это соответствующий интеграл от плотности на данном интервале (для дискретной случайной величины — просто сумма вероятностей значений из этого интервала). |

||

| Строка 180: | Строка 180: | ||

== Законы больших чисел == |

== Законы больших чисел == |

||

Важнейшее значение в теории вероятностей и в её приложениях имеет группа теорем, объединяемых обычно под названием «'''закон больших чисел'''» или '''предельных теорем'''. Не прибегая к строгим формулировкам, можно сказать, например, что при некоторых слабых условиях среднее значение независимых одинаково |

Важнейшее значение в теории вероятностей и в её приложениях имеет группа теорем, объединяемых обычно под названием «'''закон больших чисел'''» или '''предельных теорем'''. Не прибегая к строгим формулировкам, можно сказать, например, что при некоторых слабых условиях среднее значение независимых одинаково распределённых случайных величин стремится к их математическому ожиданию при достаточно большом количестве этих случайных величин. Если в качестве совокупности случайных величин рассматривать независимые наблюдения одной и той же случайной величины, то это означает, что среднее по выборочным наблюдениям должно стремиться к истинному (неизвестному) математическому ожиданию этой случайной величины. Это закон больших чисел в форме [[Чебышёв, Пафнутий Львович|Чебышёва]]. Это даёт основу для получения соответствующих оценок. |

||

Весьма частным, но очень важным случаем является схема [[Бернулли, Якоб|Бернулли]] — независимые испытания, в результате которых некоторое событие либо происходит, либо нет. Предполагается, что в каждом испытании вероятность наступления события одинакова и равна <math>p</math> (но она неизвестна). Эту схему можно свести к средней величине, если ввести формальную случайную величину X, являющуюся индикатором наступления события: она равна 1 при наступлении события и 0 при ненаступлении события. Для такой случайной величины математическое ожидание также равно <math>p</math>. Тогда среднее значение такой случайной величины — это фактически частота наступления события <math>A</math>. Согласно вышеуказанной теореме это среднее (частота) должно стремиться к истинному математическому ожиданию этой случайной величины, то есть к неизвестной вероятности <math>p</math>. Таким образом, с увеличением количества наблюдений частоту наступления события можно использовать в качестве хорошей оценки неизвестной вероятности. Это так называемый закон больших чисел Бернулли. Это закон был исторически первым законом больших чисел. Более строго можно как минимум утверждать, что вероятность того, что частота будет отклоняться от <math>p</math> на некоторую величину <math>\varepsilon</math>, стремится к нулю для любых значений <math>\varepsilon</math>. Более общий результат ([[теорема Гливенко — Кантелли]]) заключается в том, что эмпирическое распределение в целом стремится к истинному распределению вероятностей с ростом количества наблюдений. |

Весьма частным, но очень важным случаем является схема [[Бернулли, Якоб|Бернулли]] — независимые испытания, в результате которых некоторое событие либо происходит, либо нет. Предполагается, что в каждом испытании вероятность наступления события одинакова и равна <math>p</math> (но она неизвестна). Эту схему можно свести к средней величине, если ввести формальную случайную величину X, являющуюся индикатором наступления события: она равна 1 при наступлении события и 0 при ненаступлении события. Для такой случайной величины математическое ожидание также равно <math>p</math>. Тогда среднее значение такой случайной величины — это фактически частота наступления события <math>A</math>. Согласно вышеуказанной теореме это среднее (частота) должно стремиться к истинному математическому ожиданию этой случайной величины, то есть к неизвестной вероятности <math>p</math>. Таким образом, с увеличением количества наблюдений частоту наступления события можно использовать в качестве хорошей оценки неизвестной вероятности. Это так называемый закон больших чисел Бернулли. Это закон был исторически первым законом больших чисел. Более строго можно как минимум утверждать, что вероятность того, что частота будет отклоняться от <math>p</math> на некоторую величину <math>\varepsilon</math>, стремится к нулю для любых значений <math>\varepsilon</math>. Более общий результат ([[теорема Гливенко — Кантелли]]) заключается в том, что эмпирическое распределение в целом стремится к истинному распределению вероятностей с ростом количества наблюдений. |

||

Наряду с указанными теоремами существует так называемая [[центральная предельная теорема]], которая даёт предельное распределение вероятностей для средней, а именно, при определённых слабых условиях среднее значение наблюдений случайной величины при достаточно большом количестве наблюдений имеют [[нормальное распределение]] (''независимо от исходного распределения'' самой случайной величины). Например, такое имеет место для среднего значения независимых одинаково |

Наряду с указанными теоремами существует так называемая [[центральная предельная теорема]], которая даёт предельное распределение вероятностей для средней, а именно, при определённых слабых условиях среднее значение наблюдений случайной величины при достаточно большом количестве наблюдений имеют [[нормальное распределение]] (''независимо от исходного распределения'' самой случайной величины). Например, такое имеет место для среднего значения независимых одинаково распределённых случайных величин. В частности эта теорема применима и к схеме Бернулли. Вообще количество появлений события A в n испытаниях имеет [[биномиальное распределение]], однако при достаточно большом количестве наблюдений это распределение согласно указанной теореме стремится к нормальному распределению в данном случае с математическим ожиданием <math>np</math> и дисперсией <math>np(1-p)</math>, где <math>p</math> — вероятность появления события А в каждом испытании. Это утверждается в локальной и интегральной [[Локальная теорема Муавра — Лапласа|теоремах Муавра-Лапласа]]. Отсюда же следует и указанный выше вывод, а именно: среднее значение случайной величины-индикатора события — то есть ''частота'' появления события в испытаниях — будет иметь в пределе математическое ожидание <math>p</math> и дисперсию <math>p(1-p)/n</math>, которая стремится к нулю с ростом количества испытаний. Таким образом, частота стремится к истинной вероятности наступления события при увеличении количества независимых испытаний, причём мы знаем распределение частоты при достаточно большом количестве наблюдений (строго говоря в пределе частота <math>\hat{p}</math> перестаёт быть случайной величиной, поэтому корректней говорить о распределении не частоты, а величины <math>\sqrt {n} \cdot (\hat{p}-p)</math> — именно она в пределе имеет нормальное распределение с нулевым математическим ожиданием и дисперсией <math>p(1-p)</math>{{нет АИ|2|01|2021}}). |

||

== Байесовский подход к вероятности == |

== Байесовский подход к вероятности == |

||

| Строка 190: | Строка 190: | ||

В основе вышеописанного объективного (частотного) подхода лежит предположение о наличии объективной неопределённости, присущей изучаемым явлениям. В альтернативном [[Байесианизм|байесовском подходе]] неопределённость трактуется [[Субъективность|субъективно]] — как мера нашего незнания. В рамках байесовского подхода под вероятностью понимается степень уверенности в истинности суждения — субъективная вероятность. |

В основе вышеописанного объективного (частотного) подхода лежит предположение о наличии объективной неопределённости, присущей изучаемым явлениям. В альтернативном [[Байесианизм|байесовском подходе]] неопределённость трактуется [[Субъективность|субъективно]] — как мера нашего незнания. В рамках байесовского подхода под вероятностью понимается степень уверенности в истинности суждения — субъективная вероятность. |

||

Идея байесовского подхода заключается в переходе от [[Априори|априорных]] знаний к [[апостериорная вероятность|апостерирорным]] с учётом наблюдаемых явлений. Суть байесовского подхода следует из описанной выше формулы Байеса. Пусть имеются полный набор гипотез <math>A_i</math>, |

Идея байесовского подхода заключается в переходе от [[Априори|априорных]] знаний к [[апостериорная вероятность|апостерирорным]] с учётом наблюдаемых явлений. Суть байесовского подхода следует из описанной выше формулы Байеса. Пусть имеются полный набор гипотез <math>A_i</math>, причём из априорных соображений оценены вероятности справедливости этих гипотез (степень уверенности в них). Полнота набора означает, что хотя бы одна из этих гипотез верна и сумма априорных вероятностей <math>\Pr(A_i)</math> равна 1. Также для изучаемого события <math>B</math> из априорных соображений известны вероятности <math>\Pr(B\mid A_i)</math> — вероятности наступления события <math>B</math>, при условии справедливости гипотезы <math>A_i</math>. Тогда с помощью формулы Байеса можно определить апостериорные вероятности <math>\Pr(A_j\mid B)</math> — то есть степень уверенности в справедливости гипотезы <math>A_j</math> после того, как событие <math>B</math> произошло. Собственно, процедуру можно повторить принимая новые вероятности за априорные и снова делая испытание, тем самым итеративно уточняя апостериорные вероятности гипотез. |

||

В частности в отличие от базового подхода к оценке распределений случайных величин, где предполагается, что на основе наблюдений оцениваются значения неизвестных параметров распределений, в байесовском подходе предполагается что параметры — тоже случайные величины (с точки зрения нашего незнания их значений). В качестве гипотез выступают те или иные возможные значения параметров и предполагаются данными некоторые априорные плотности неизвестных параметров <math>p(\theta)</math>. В качестве оценки неизвестных параметров выступает апостериорное распределение. Пусть в результате наблюдений получены некоторые значения <math>x</math> изучаемой случайной величины. Тогда для значений данной выборки предполагая известным правдоподобие — вероятность (плотность) получения данной выборки при данных значениях параметров <math>p(x\mid \theta)</math>, по формуле Байеса (в данном случае непрерывный аналог этой формулы, где вместо вероятностей участвуют плотности, а суммирование заменено интегрированием) получим апостериорную вероятность (плотность) <math>p(\theta\mid x)</math> параметров при данной выборке. |

В частности в отличие от базового подхода к оценке распределений случайных величин, где предполагается, что на основе наблюдений оцениваются значения неизвестных параметров распределений, в байесовском подходе предполагается что параметры — тоже случайные величины (с точки зрения нашего незнания их значений). В качестве гипотез выступают те или иные возможные значения параметров и предполагаются данными некоторые априорные плотности неизвестных параметров <math>p(\theta)</math>. В качестве оценки неизвестных параметров выступает апостериорное распределение. Пусть в результате наблюдений получены некоторые значения <math>x</math> изучаемой случайной величины. Тогда для значений данной выборки предполагая известным правдоподобие — вероятность (плотность) получения данной выборки при данных значениях параметров <math>p(x\mid \theta)</math>, по формуле Байеса (в данном случае непрерывный аналог этой формулы, где вместо вероятностей участвуют плотности, а суммирование заменено интегрированием) получим апостериорную вероятность (плотность) <math>p(\theta\mid x)</math> параметров при данной выборке. |

||

| Строка 196: | Строка 196: | ||

== Вероятность, информация и энтропия == |

== Вероятность, информация и энтропия == |

||

{{seealso|Информация|Энтропия}} |

{{seealso|Информация|Энтропия}} |

||

Пусть имеется <math>N</math> равновероятных исходов. Степень неопределённости опыта в этой ситуации можно характеризовать числом <math>H=\log_2 N</math>. Этот показатель, введённый инженером-связистом Хартли в 1928 году характеризует информацию, которую необходимо иметь, чтобы знать какой именно из <math>N</math> равновозможных вариантов имеет место, то есть свести неопределённость опыта к нулю. Простейший способ выяснить это — задать вопросы типа «номер исхода меньше половины N», если да, то аналогичный вопрос можно задать и для одной из половин (в зависимости от ответа на вопрос) и т. д. Ответ на каждый подобный вопрос сокращает неопределённость. Всего таких вопросов для полного снятия неопределённости понадобится как раз <math>H</math>. Более формально, номера исходов можно представить в двоичной системе счисления, тогда <math>H</math> — это количество необходимых разрядов для такого представления, то есть количество информации в [[бит]]ах, с помощью которого можно закодировать реализацию равновозможных исходов. В общем случае, единица информации может быть и иной, поэтому логарифм теоретически можно использовать с любым основанием (например, если мы хотим изменять информацию в байтах, то нужно использовать логарифм по основанию 256). |

Пусть имеется <math>N</math> равновероятных исходов. Степень неопределённости опыта в этой ситуации можно характеризовать числом <math>H = \log_2 N</math>. Этот показатель, введённый инженером-связистом Хартли в 1928 году характеризует информацию, которую необходимо иметь, чтобы знать какой именно из <math>N</math> равновозможных вариантов имеет место, то есть свести неопределённость опыта к нулю. Простейший способ выяснить это — задать вопросы типа «номер исхода меньше половины ''N''», если да, то аналогичный вопрос можно задать и для одной из половин (в зависимости от ответа на вопрос) и т. д. Ответ на каждый подобный вопрос сокращает неопределённость. Всего таких вопросов для полного снятия неопределённости понадобится как раз <math>H</math>. Более формально, номера исходов можно представить в двоичной системе счисления, тогда <math>H</math> — это количество необходимых разрядов для такого представления, то есть количество информации в [[бит]]ах, с помощью которого можно закодировать реализацию равновозможных исходов. В общем случае, единица информации может быть и иной, поэтому логарифм теоретически можно использовать с любым основанием (например, если мы хотим изменять информацию в байтах, то нужно использовать логарифм по основанию 256). |

||

Пусть теперь задана некоторая [[случайная величина]] α, распределённая на <math>N</math> исходах <math>a_1,a_2,\dotsc,a_N</math> с вероятностями <math>p_1,p_2,\ |

Пусть теперь задана некоторая [[случайная величина]] α, распределённая на <math>N</math> исходах <math>a_1,a_2,\dotsc,a_N</math> с вероятностями <math>p_1, p_2, \dots, p_N</math>, <math>\textstyle \sum_i p_i = 1</math>, тогда количество информации в случайной величине α определяется следующим образом ([[формула Шеннона]]): |

||

: <math>H(\alpha) = \sum_i p_i\log_2\frac{1}{p_i} = -\sum_i p_i\log_2 p_i = -\mathop{\mathbb E}\limits_{a\gets \alpha}[\log_2 \Pr(\alpha = a)],</math> |

|||

где <math>\mathbb E</math> — знак [[Математическое ожидание|математического ожидания]]. |

где <math>\mathbb E</math> — знак [[Математическое ожидание|математического ожидания]]. |

||

При равновероятных исходах (<math>p_i=1/N</math>) получаем уже известное соотношение <math>H(\alpha)=\log_2 N</math>. Для непрерывной случайной величины в этой формуле необходимо использовать вместо вероятностей — функцию плотности распределения и вместо суммы — соответствующий интеграл. |

При равновероятных исходах (<math>p_i = 1/N</math>) получаем уже известное соотношение <math>H(\alpha) = \log_2 N</math>. Для непрерывной случайной величины в этой формуле необходимо использовать вместо вероятностей — функцию плотности распределения и вместо суммы — соответствующий интеграл. |

||

Указанную величину называют ''информацией, информационным количеством |

Указанную величину называют ''информацией, информационным количеством'', [[информационная энтропия|информационной энтропией]] и т. д. Такое определение информации абстрагируется от какого-либо содержания информации, содержания конкретных исходов. Информационное количество определяется только на основе вероятностей. Величину <math>H</math> Шеннон назвал [[энтропия|энтропией]] в связи со схожестью с термодинамической энтропией. Последнее понятие впервые ввёл [[Клаузис|Рудольф Клаузис]] в 1865 году, а вероятностное толкование энтропии дал [[Людвиг Больцман]] в 1877 году. Энтропия макроскопической системы — это мера числа возможных микросостояний для данного макросостояния (более конкретно она пропорциональна логарифму количества микросостояний — [[статистический вес|статистическому весу]]) или мера «внутреннего беспорядка» макросистемы. |

||

== Вероятность и квантовая физика == |

== Вероятность и квантовая физика == |

||

| Строка 234: | Строка 234: | ||

== Литература == |

== Литература == |

||

* {{книга |автор=[[Альфред Реньи]]|заглавие=Письма о вероятности |ответственный=Пер. с венг. Д. Сааса и А. Крамли под ред. Б. В. Гнеденко |место=М. |издательство=Мир |год=1970 |ссылка= |

* {{книга |автор=[[Альфред Реньи]]|заглавие=Письма о вероятности |ответственный=Пер. с венг. Д. Сааса и А. Крамли под ред. Б. В. Гнеденко |место=М. |издательство=Мир |год=1970 |ссылка=https://istmat.org/node/30131}} |

||

* {{книга |часть=Вероятность в физике |ссылка часть=http://yunc.org/%D0%92%D0%95%D0%A0%D0%9E%D0%AF%D0%A2%D0%9D%D0%9E%D0%A1%D0%A2%D0%AC_%D0%92_%D0%A4%D0%98%D0%97%D0%98%D0%9A%D0%95 |

* {{книга |часть=Вероятность в физике |ссылка часть=http://yunc.org/%D0%92%D0%95%D0%A0%D0%9E%D0%AF%D0%A2%D0%9D%D0%9E%D0%A1%D0%A2%D0%AC_%D0%92_%D0%A4%D0%98%D0%97%D0%98%D0%9A%D0%95 |

||

| заглавие = [[Энциклопедический словарь (Педагогика)|Энциклопедический словарь]] юного физика |

| заглавие = [[Энциклопедический словарь (Педагогика)|Энциклопедический словарь]] юного физика |

||

Текущая версия от 09:24, 28 октября 2024

Вероя́тность — степень (относительная мера, количественная оценка) возможности наступления некоторого события. Когда основания для того, чтобы какое-нибудь возможное событие произошло в действительности, перевешивают противоположные основания, то это событие называют вероятным, в противном случае — маловероятным или невероятным. Перевес положительных оснований над отрицательными, и наоборот, может быть в различной степени, вследствие чего вероятность (и невероятность) бывает большей либо меньшей[1]. Поэтому часто вероятность оценивается на качественном уровне, особенно в тех случаях, когда более или менее точная количественная оценка невозможна или крайне затруднена. Возможны различные градации «уровней» вероятности[2].

Исследование вероятности с математической точки зрения составляет особую дисциплину — теорию вероятностей[1]. В теории вероятностей и математической статистике понятие вероятности формализуется как числовая характеристика события — вероятностная мера (или её значение) — мера на множестве событий (подмножеств множества элементарных событий), принимающая значения от до (в научно-популярных текстах и в быту также применяется процентная запись, сопоставляющая 100 % единице). Значение соответствует достоверному событию. Невозможное событие имеет вероятность 0 (обратное, вообще говоря, не всегда верно). Если вероятность наступления события равна , то вероятность его ненаступления (а также невероятность наступления) равна . В частности, вероятность означает равную вероятность наступления и ненаступления события.

Классическое определение вероятности основано на понятии равновозможности исходов. В качестве вероятности выступает отношение количества исходов, благоприятствующих данному событию, к общему числу равновозможных исходов. Например, вероятности выпадения «орла» или «решки» при случайном подбрасывании монеты одинаковы и равны , вероятности выпадения любой грани игральной кости одинаковы и равны . Данное классическое «определение» вероятности можно обобщить на случай бесконечного количества возможных значений — например, если некоторое событие может произойти с равной вероятностью в любой точке (количество точек бесконечно) некоторой ограниченной области пространства (плоскости), то вероятность того, что оно произойдёт в некоторой части этой допустимой области равна отношению объёма (площади) этой части к объёму (площади) области всех возможных точек.

Эмпирическое «определение» вероятности связано с частотой наступления события исходя из того, что при достаточно большом числе испытаний частота должна стремиться к объективной степени возможности этого события. В современном изложении теории вероятностей вероятность определяется аксиоматически, как частный случай абстрактной теории меры множества. Тем не менее, связующим звеном между абстрактной мерой и вероятностью, выражающей степень возможности наступления события, является именно частота его наблюдения.

Вероятностное описание тех или иных явлений получило широкое распространение в современной науке, в частности в эконометрике, статистической физике макроскопических (термодинамических) систем, где даже в случае классического детерминированного описания движения частиц детерминированное описание всей системы частиц не представляется практически возможным и целесообразным. В квантовой физике сами описываемые процессы имеют вероятностную природу.

История

[править | править код]

Предыстория понятия вероятности

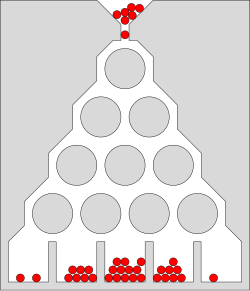

[править | править код]Необходимость понятия вероятности и исследований в этом направлении была исторически связана с азартными играми, особенно с играми в кости. До появления понятия вероятности формулировались в основном комбинаторные задачи подсчёта числа возможных исходов при бросании нескольких костей, а также задача раздела ставки между игроками, когда игра закончена досрочно. Первую задачу при бросании трёх костей «решил» в 960 году епископ Виболд из г. Камбре[3]. Он насчитал 56 вариантов. Однако это количество, по сути, не отражает количество равновероятных возможностей, поскольку каждый из 56 вариантов может реализоваться разным количеством способов. В первой половине XIII века эти аспекты учёл Ришар де Форниваль. Несмотря на то, что у него тоже фигурирует число 56, в рассуждениях он отмечает, что «одинаковое количество очков на трёх костях можно получить шестью способами». Основываясь на его рассуждениях, можно установить, что число равновозможных вариантов — 216. В дальнейшем многие не совсем верно решали эту задачу. Впервые точное количество равновозможных исходов при подбрасывании трёх костей подсчитал Галилео Галилей, возводя шестёрку (количество вариантов выпадения одной кости) в степень 3 (количество костей): 6³=216. Он же составил таблицы количества способов получения различных сумм очков.

В конце XV века Лука Пачоли[3] сформулировал задачи второго типа и предложил первое решение (которое было ошибочным). Его решение заключалось в делении ставки пропорционально выигранным партиям. В начале XVI века продвижение исследований в области формулирования комбинаторных задач подсчёта числа возможных исходов при бросании костей связано с именами итальянских учёных Джероламо Кардано и Н. Тарталья. Кардано дал правильный подсчёт количества случаев при бросании двух костей (36). Он также впервые соотнёс количество случаев выпадения некоторого числа хотя бы на одной кости (11) к общему числу исходов (что соответствует классическому определению вероятности) — 11/36. Аналогично и для трёх костей он рассматривал, например, что девять очков может получиться количеством способов, равным 1/9 «всей серии» (то есть общего количества равновозможных исходов — 216). Кардано формально не вводил понятие вероятности, но по существу рассматривал относительное количество исходов, что по сути эквивалентно рассмотрению вероятностей. Также в его работах можно найти идеи, связанные с законом больших чисел. По поводу задачи деления ставки Кардано предлагал учитывать количество оставшихся партий, которые надо выиграть. Н. Тарталья также делал замечания по поводу решения Луки и предложил своё решение, тоже ошибочное.

Заслуга Галилея также заключается в расширении круга исследований на область ошибок наблюдений. Он впервые указал на неизбежность ошибок и классифицировал их на систематические и случайные (такая классификация применяется и сейчас).

Возникновение понятия и теории вероятностей

[править | править код]К первым работам, посвящённым понятию вероятности, можно отнести переписку французских учёных Б. Паскаля, П. Ферма (1654 год) и нидерландского учёного X. Гюйгенса (1657 год), давшего самую раннюю из известных научных трактовок вероятности[4]. По существу, Гюйгенс уже оперировал понятием математического ожидания. В конце XVII века швейцарский математик Я. Бернулли установил закон больших чисел для схемы независимых испытаний с двумя исходами (результат был опубликован в 1713 году, уже после его смерти).

В XVIII в. — начале XIX в. теория вероятностей получает развитие в работах А. Муавра (Англия, 1718 год), П. Лаплас (Франция), К. Гаусса (Германия) и С. Пуассона (Франция). Теория вероятностей начинает применяться в теории ошибок наблюдений, развившейся в связи с потребностями геодезии и астрономии, и в теории стрельбы. Лаплас предложил закон распределения ошибок сначала как экспоненциальную зависимость от ошибки без учёта знака (в 1774 году), затем как экспоненциальную функцию квадрата ошибки (в 1778 году). Последний закон обычно называют распределением Гаусса или нормальным распределением. Бернулли (1778 год) ввёл принцип произведения вероятностей одновременных событий. Адриен Мари Лежандр (1805) разработал метод наименьших квадратов.

Во второй половине XIX в. развитие теории вероятностей связано с работами русских математиков П. Л. Чебышёва, А. М. Ляпунова и А. А. Маркова (старшего), а также работы по математической статистике А. Кетле (Бельгия) и Ф. Гальтона (Англия) и статистической физике Л. Больцмана (в Австрии), которые создали основу для существенного расширения проблематики теории вероятностей. Наиболее распространённая в настоящее время логическая (аксиоматическая) схема построения основ теории вероятностей разработана в 1933 советским математиком А. Н. Колмогоровым.

Определения вероятности

[править | править код]Классическое определение

[править | править код]Классическое «определение» вероятности исходит из понятия равновозможности как объективного свойства изучаемых явлений. Равновозможность является неопределяемым понятием и устанавливается из общих соображений симметрии изучаемых явлений. Например, при подбрасывании монетки исходят из того, что в силу предполагаемой симметрии монетки, однородности материала и случайности (непредвзятости) подбрасывания нет никаких оснований для предпочтения «решки» перед «орлом» или наоборот, то есть выпадение этих сторон можно считать равновозможными (равновероятными).

Наряду с понятием равновозможности в общем случае для классического определения необходимо также понятие элементарного события (исхода), благоприятствующего или нет изучаемому событию A. Речь идёт об исходах, наступление которых исключает возможность наступления иных исходов. Это несовместимые элементарные события. К примеру, при бросании игральной кости выпадение конкретного числа исключает выпадение остальных чисел.

Классическое определение вероятности можно сформулировать следующим образом:

Вероятностью случайного события A называется отношение числа n несовместимых равновероятных элементарных событий, составляющих событие A, к числу всех возможных элементарных событий N:

Например, пусть подбрасываются две кости. Общее количество равновозможных исходов (элементарных событий) равно 36 (так как на каждый из 6 возможных исходов одной кости возможно по 6 вариантов исхода другой). Оценим вероятность выпадения семи очков. Получить 7 очков можно лишь при следующих сочетаниях исходов броска двух костей: 1+6, 2+5, 3+4, 4+3, 5+2, 6+1. То есть всего 6 равновозможных исходов, благоприятствующих получению 7 очков, из 36 возможных исходов броска костей. Следовательно, вероятность будет равна 6/36 или, если сократить, 1/6. Для сравнения: вероятность получения 12 очков или 2 очков равна всего 1/36 — в 6 раз меньше.

Геометрическое определение

[править | править код]Несмотря на то, что классическое определение является интуитивно понятным и выведенным из практики, оно, как минимум, не может быть непосредственно применено в случае, если количество равновозможных исходов бесконечно. Ярким примером бесконечного числа возможных исходов является ограниченная геометрическая область G, например, на плоскости с площадью S. Случайно «подброшенная точка» с равной вероятностью может оказаться в любой точке этой области. Задача заключается в определении вероятности попадания точки в некоторую подобласть g с площадью s. В таком случае, обобщая классическое определение, можно прийти к геометрическому определению вероятности попадания в подобласть :

В виду равновозможности эта вероятность не зависит от формы области g, она зависит только от её площади. Данное определение естественно можно обобщить и на пространство любой размерности, где вместо площади использовать понятие «объёма». Более того, именно такое определение приводит к современному аксиоматическому определению вероятности. Понятие объёма обобщается до понятия меры некоторого абстрактного множества, к которой предъявляются требования, которыми обладает и «объём» в геометрической интерпретации — в первую очередь, это неотрицательность и аддитивность.

Частотное (статистическое) определение

[править | править код]Классическое определение при рассмотрении сложных проблем наталкивается на трудности непреодолимого характера. В некоторых случаях выявить равновозможные случаи может быть невозможно. Даже в случае с монеткой, как известно, существует явно не равновероятная возможность выпадения «ребра», которую из теоретических соображений оценить невозможно (можно только сказать, что оно маловероятно и это соображение скорее практическое). Поэтому ещё на заре становления теории вероятностей было предложено альтернативное «частотное» определение вероятности. А именно, формально вероятность можно определить как предел частоты наблюдений события A, предполагая однородность наблюдений (то есть одинаковость всех условий наблюдения) и их независимость друг от друга:

где — количество наблюдений, а — количество наступлений события .

Несмотря на то, что данное определение скорее указывает на способ оценки неизвестной вероятности — путём большого количества однородных и независимых наблюдений — тем не менее в таком определении отражено содержание понятия вероятности. А именно, если событию приписывается некоторая вероятность, как объективная мера его возможности, то это означает, что при фиксированных условиях и многократном повторении мы должны получить частоту его появления, близкую к (тем более близкую, чем больше наблюдений). Собственно, в этом заключается исходный смысл понятия вероятности. В основе лежит объективистский взгляд на явления природы. Ниже будут рассмотрены так называемые законы больших чисел, которые дают теоретическую основу (в рамках излагаемого ниже современного аксиоматического подхода) в том числе для частотной оценки вероятности.

Философские проблемы обоснования

[править | править код]К моменту создания теории вероятностей основой математики были два класса объектов — числа и геометрические фигуры. Для теории вероятностей потребовалось добавить в этот список совершенно особый объект: случайное событие, а также тесно связанные с ним понятия (вероятность, случайная величина и др.). Своеобразие новой науки проявлялось и в том, что её утверждения носили не безусловный характер, как ранее было принято в математике, а предположительно-вероятностный. Поэтому долгое время не прекращались споры о том, можно ли считать идеализированное событие математическим понятием (и тогда теория вероятностей есть часть математики) или же это факт, наблюдаемый в опыте (и тогда теорию вероятностей следует отнести к естественным наукам).

По мнению Давида Гильберта, теория вероятностей родственна механике, то есть представляет собой математизированную «физическую дисциплину»[5]. Август де Морган и его последователь У. С. Джевонс считали базовым понятием «субъективную вероятность», то есть количественную меру нашего понимания предмета исследования, и связывали теорию вероятностей с логикой[6]. Проблемы, связанные с неоднозначной субъективной вероятностью, неоднократно обсуждались, их часто формулируют в виде «вероятностных парадоксов» (см., например, «парадокс трёх узников» или «парадокс мальчика и девочки»). Формализацию субъективной вероятности, совместимую с колмогоровской, предложили Бруно де Финетти (1937) и Леонард Сэвидж (1954).

Во второй половине XX века Альфред Реньи и А. Н. Колмогоров исследовали возможность дать обоснование теории вероятностей на базе теории информации[7]. В наши дни «сложилось чёткое понимание того, что теория вероятностей является подлинно математической наукой, имеющей вместе с тем самые тесные и непосредственные связи с широким спектром наук о природе, а также с техническими и социально-экономическими дисциплинами»[8].

Несмотря на доказанную практикой эффективность вероятностных методов, роль случайности в природе, причина и границы статистической устойчивости остаются предметом дискуссий[9]. «За 200 лет, прошедших со времён Лапласа и Гаусса, наука не добилась продвижения в фундаментальном вопросе — когда возникает статистическая устойчивость»[10].

Аксиоматическое определение

[править | править код]В современном математическом подходе вероятность задаётся аксиоматикой Колмогорова. Предполагается, что задано некоторое пространство элементарных событий . Подмножества этого пространства интерпретируются как случайные события. Объединение (сумма) некоторых подмножеств (событий) интерпретируется как событие, заключающееся в наступлении хотя бы одного из этих событий. Пересечение (произведение) подмножеств (событий) интерпретируется как событие, заключающееся в наступлении всех этих событий. Непересекающиеся множества интерпретируются как несовместные события (их совместное наступление невозможно). Соответственно, пустое множество означает невозможное событие.

Вероятностью (вероятностной мерой) называется мера (числовая функция) , заданная на множестве событий, обладающая следующими свойствами:

- Неотрицательность: ,

- Аддитивность: вероятность наступления хотя бы одного (то есть суммы) из попарно несовместных событий равна сумме вероятностей этих событий; другими словами, если при , то .

- Конечность (ограниченность единицей): ,

В случае если пространство элементарных событий X конечно, то достаточно указанного условия аддитивности для произвольных двух несовместных событий, из которого будет следовать аддитивность для любого конечного количества несовместных событий. Однако, в случае бесконечного (счётного или несчётного) пространства элементарных событий этого условия оказывается недостаточно. Требуется так называемая счётная или сигма-аддитивность, то есть выполнение свойства аддитивности для любого не более чем счётного семейства попарно несовместных событий. Это необходимо для обеспечения «непрерывности» вероятностной меры.

Вероятностная мера может быть определена не для всех подмножеств множества . Предполагается, что она определена на некоторой сигма-алгебре подмножеств[11]. Эти подмножества называются измеримыми по данной вероятностной мере и именно они являются случайными событиями. Совокупность — то есть множество элементарных событий, сигма-алгебра его подмножеств и вероятностная мера — называется вероятностным пространством.

Свойства вероятности

[править | править код]Основные свойства вероятности проще всего определить, исходя из аксиоматического определения вероятности.

1) вероятность невозможного события (пустого множества ) равна нулю:

Это следует из того, что каждое событие можно представить как сумму этого события и невозможного события, что в силу аддитивности и конечности вероятностной меры означает, что вероятность невозможного события должна быть равна нулю.

2) если событие A включается («входит») в событие B, то есть , то есть наступление события A влечёт также наступление события B, то

Это следует из неотрицательности и аддитивности вероятностной меры, так как событие , возможно, «содержит» кроме события ещё какие-то другие события, несовместные с .

3) вероятность каждого события находится от 0 до 1, то есть удовлетворяет неравенствам

Первая часть неравенства (неотрицательность) утверждается аксиоматически, а вторая следует из предыдущего свойства с учётом того, что любое событие «входит» в , а для аксиоматически предполагается

4) вероятность наступления события , где , заключающегося в наступлении события при одновременном ненаступлении события , равна

Это следует из аддитивности вероятности для несовместных событий и из того, что события и являются несовместными по условию, а их сумма равна событию .

5) вероятность события , противоположного событию , равна

Это следует из предыдущего свойства, если в качестве множества использовать всё пространство и учесть, что

6) (теорема сложения вероятностей) вероятность наступления хотя бы одного из (то есть суммы) произвольных (не обязательно несовместных) двух событий и равна

Это свойство можно получить, если представить объединение двух произвольных множеств как объединение двух непересекающихся — первого и разности между вторым и пересечением исходных множеств: . Отсюда, учитывая аддитивность вероятности для непересекающихся множеств и формулу для вероятности разности (см. свойство 4) множеств, получаем требуемое свойство.

Условная вероятность

[править | править код]Формула Байеса

[править | править код]Вероятность наступления события , при условии наступления события , называется условной вероятностью (при данном условии) и обозначается . Наиболее просто вывести формулу определения условной вероятности исходя из классического определения вероятности. Для данных двух событий и рассмотрим следующий набор несовместных событий: , которые исчерпывают все возможные варианты исходов (такой набор событий называют полным — см. ниже). Общее количество равновозможных исходов равно . Если событие уже наступило, то равновозможные исходы ограничивается лишь двумя событиями , что эквивалентно событию . Пусть количество этих исходов равно . Из этих исходов событию благоприятствуют лишь те, что связаны с событием . Количество соответствующих исходов обозначим . Тогда согласно классическому определению вероятности вероятность события при условии наступления события будет равна , разделив числитель и знаменатель на общее количество равновозможных исходов и повторно учитывая классическое определение, окончательно получим формулу условной вероятности:

- .

Отсюда следует так называемая теорема умножения вероятностей:

- .

В силу симметрии, аналогично можно показать, что также , отсюда следует формула Байеса:

Независимость событий

[править | править код]События A и B называются независимыми, если вероятность наступления одного из них не зависит от того, наступило ли другое событие. С учётом понятия условной вероятности это означает, что , откуда следует, что для независимых событий выполняется равенство

В рамках аксиоматического подхода данная формула принимается как определение понятия независимости двух событий. Для произвольной (конечной) совокупности событий их независимость в совокупности означает, что вероятность их совместного наступления равна произведению их вероятностей:

Выведенная (в рамках классического определения вероятности) выше формула условной вероятности при аксиоматическом определении вероятности является определением условной вероятности. Соответственно, как следствие определений независимых событий и условной вероятности, получается равенство условной и безусловной вероятностей события.

Полная вероятность и формула Байеса

[править | править код]Набор событий , хотя бы одно из которых обязательно (с единичной вероятностью) наступит в результате испытания, называется полным. Это означает, что набор таких событий исчерпывает все возможные варианты исходов. Формально в рамках аксиоматического подхода это означает, что . Если эти события несовместны, то в рамках классического определения это означает, что сумма количеств элементарных событий, благоприятствующих тому или иному событию, равно общему количеству равновозможных исходов.

Пусть имеется полный набор попарно несовместных событий . Тогда для любого события верна следующая формула расчёта его вероятности (формула полной вероятности):

Тогда вышеописанную формулу Байеса с учётом полной вероятности можно записать в следующем виде:

Данная формула является основой альтернативного подхода к вероятности — байесовского или субъективного подхода (см. ниже).

Вероятность и случайные величины

[править | править код]Важнейший частный случай применения «вероятности» — вероятность получения в результате испытания или наблюдения того или иного числового значения некоторой измеряемой (наблюдаемой) величины. Предполагается, что до проведения испытания (наблюдения) точное значение этой величины неизвестно, то есть имеется явная неопределённость, связанная обычно (за исключением квантовой физики) с невозможностью учёта всех факторов, влияющих на результат. Такие величины называют случайными. В современной теории вероятностей понятие случайной величины формализуется и она определяется как функция «случая» — функция на пространстве элементарных событий. При таком определении наблюдаются не сами элементарные события, а «реализации», конкретные значения случайной величины. Например, при подбрасывании монетки выпадает «решка» или «орёл». Если ввести функцию, ставящую в соответствие «решке» — число 1, а «орлу» — 0, то получим случайную величину как функцию указанных исходов. При этом понятие случайной величины обобщается на функции, отображающие пространство элементарных событий в некоторое пространство произвольной природы, соответственно можно ввести понятия случайного вектора, случайного множества и т. д. Однако, обычно под случайной величиной подразумевают именно числовую функцию (величину).

Отвлекаясь от описанной формализации под пространством элементарных событий можно понимать множество возможных значений случайной величины. Сигма-алгеброй подмножеств являются произвольные интервалы на числовой оси, их всевозможные (счётные) объединения и пересечения. Вероятностную меру называют в данном случае распределением случайной величины. Достаточно задать вероятностную меру для интервалов вида , поскольку произвольный интервал можно представить как объединение или пересечение таких интервалов. Предполагается, что каждому интервалу вышеуказаного вида поставлена в соответствие некоторая вероятность , то есть некоторая функция возможных значений . Такую функцию называют интегральной, кумулятивной или просто функцией распределения случайной величины. В случае дифференцируемости этой функции (в этом случае соответствующие случайные величины называются непрерывными) вводится также аналитически часто более удобная функция — плотность распределения — производная функции распределения: . В случае дискретных случайных величин вместо плотности (она не существует в этом случае) можно использовать непосредственно ряд распределения — вероятность -го значения. Соответствующая функция распределения будет связана с рядом распределения как: . Вероятность того, что случайная величина окажется в некотором интервале определяется как разность значений функции распределения на концах этого интервала. Через плотность распределения — это соответствующий интеграл от плотности на данном интервале (для дискретной случайной величины — просто сумма вероятностей значений из этого интервала).

Распределение случайной величины даёт её полную характеристику. Однако, часто используют отдельные характеристики этого распределения. В первую очередь это математическое ожидание случайной величины — среднее ожидаемое значение случайной величины с учётом взвешивания по вероятностям появления тех или иных значений, и дисперсия или вариация — средний квадрат отклонения случайной величины от её математического ожидания. В некоторых случаях используются и иные характеристики, среди которых важное значение имеют асимметрия и эксцесс. Описанные показатели являются частными случаями так называемых моментов распределения.

Существуют некоторые стандартные законы распределения, часто используемые на практике. В первую очередь — это нормальное распределение (распределение Гаусса). Оно полностью характеризуется двумя параметрами — математическим ожиданием и дисперсией. Его широкое использование связано, в частности, с так называемыми предельными теоремами (см. ниже). При проверке гипотез часто возникают распределения Хи-квадрат, распределение Стьюдента, распределение Фишера. При анализе дискретных случайных величин рассматриваются биномиальное распределение, распределение Пуассона и др. Также часто рассматривается гамма-распределение, частным случаем которого является экспоненциальное распределение, а также указанное выше распределение Хи-квадрат Естественно, используемые на практике распределения не ограничиваются только этими распределениями.

Часто на практике исходя из априорных соображений делается предположение, что распределение вероятностей данной случайной величины относится к некоторому известному с точностью до параметров распределению. Например, к тому же нормальному распределению, но с неизвестным математическим ожиданием и дисперсией (эти два параметра однозначно определяют все нормальное распределение). Задачей статистических наук (математическая статистика, эконометрика и т. д.) в таком случае является оценка значений этих параметров наиболее эффективным (точным) способом. Существуют критерии, с помощью которых можно установить степень «истинности» соответствующих методов оценки. Обычно требуется как минимум состоятельность оценки, несмещённость и эффективность в некотором классе оценок.

На практике применяются также непараметрические методы оценки распределений.

Законы больших чисел

[править | править код]Важнейшее значение в теории вероятностей и в её приложениях имеет группа теорем, объединяемых обычно под названием «закон больших чисел» или предельных теорем. Не прибегая к строгим формулировкам, можно сказать, например, что при некоторых слабых условиях среднее значение независимых одинаково распределённых случайных величин стремится к их математическому ожиданию при достаточно большом количестве этих случайных величин. Если в качестве совокупности случайных величин рассматривать независимые наблюдения одной и той же случайной величины, то это означает, что среднее по выборочным наблюдениям должно стремиться к истинному (неизвестному) математическому ожиданию этой случайной величины. Это закон больших чисел в форме Чебышёва. Это даёт основу для получения соответствующих оценок.

Весьма частным, но очень важным случаем является схема Бернулли — независимые испытания, в результате которых некоторое событие либо происходит, либо нет. Предполагается, что в каждом испытании вероятность наступления события одинакова и равна (но она неизвестна). Эту схему можно свести к средней величине, если ввести формальную случайную величину X, являющуюся индикатором наступления события: она равна 1 при наступлении события и 0 при ненаступлении события. Для такой случайной величины математическое ожидание также равно . Тогда среднее значение такой случайной величины — это фактически частота наступления события . Согласно вышеуказанной теореме это среднее (частота) должно стремиться к истинному математическому ожиданию этой случайной величины, то есть к неизвестной вероятности . Таким образом, с увеличением количества наблюдений частоту наступления события можно использовать в качестве хорошей оценки неизвестной вероятности. Это так называемый закон больших чисел Бернулли. Это закон был исторически первым законом больших чисел. Более строго можно как минимум утверждать, что вероятность того, что частота будет отклоняться от на некоторую величину , стремится к нулю для любых значений . Более общий результат (теорема Гливенко — Кантелли) заключается в том, что эмпирическое распределение в целом стремится к истинному распределению вероятностей с ростом количества наблюдений.

Наряду с указанными теоремами существует так называемая центральная предельная теорема, которая даёт предельное распределение вероятностей для средней, а именно, при определённых слабых условиях среднее значение наблюдений случайной величины при достаточно большом количестве наблюдений имеют нормальное распределение (независимо от исходного распределения самой случайной величины). Например, такое имеет место для среднего значения независимых одинаково распределённых случайных величин. В частности эта теорема применима и к схеме Бернулли. Вообще количество появлений события A в n испытаниях имеет биномиальное распределение, однако при достаточно большом количестве наблюдений это распределение согласно указанной теореме стремится к нормальному распределению в данном случае с математическим ожиданием и дисперсией , где — вероятность появления события А в каждом испытании. Это утверждается в локальной и интегральной теоремах Муавра-Лапласа. Отсюда же следует и указанный выше вывод, а именно: среднее значение случайной величины-индикатора события — то есть частота появления события в испытаниях — будет иметь в пределе математическое ожидание и дисперсию , которая стремится к нулю с ростом количества испытаний. Таким образом, частота стремится к истинной вероятности наступления события при увеличении количества независимых испытаний, причём мы знаем распределение частоты при достаточно большом количестве наблюдений (строго говоря в пределе частота перестаёт быть случайной величиной, поэтому корректней говорить о распределении не частоты, а величины — именно она в пределе имеет нормальное распределение с нулевым математическим ожиданием и дисперсией [источник не указан 1442 дня]).

Байесовский подход к вероятности

[править | править код]В основе вышеописанного объективного (частотного) подхода лежит предположение о наличии объективной неопределённости, присущей изучаемым явлениям. В альтернативном байесовском подходе неопределённость трактуется субъективно — как мера нашего незнания. В рамках байесовского подхода под вероятностью понимается степень уверенности в истинности суждения — субъективная вероятность.

Идея байесовского подхода заключается в переходе от априорных знаний к апостерирорным с учётом наблюдаемых явлений. Суть байесовского подхода следует из описанной выше формулы Байеса. Пусть имеются полный набор гипотез , причём из априорных соображений оценены вероятности справедливости этих гипотез (степень уверенности в них). Полнота набора означает, что хотя бы одна из этих гипотез верна и сумма априорных вероятностей равна 1. Также для изучаемого события из априорных соображений известны вероятности — вероятности наступления события , при условии справедливости гипотезы . Тогда с помощью формулы Байеса можно определить апостериорные вероятности — то есть степень уверенности в справедливости гипотезы после того, как событие произошло. Собственно, процедуру можно повторить принимая новые вероятности за априорные и снова делая испытание, тем самым итеративно уточняя апостериорные вероятности гипотез.

В частности в отличие от базового подхода к оценке распределений случайных величин, где предполагается, что на основе наблюдений оцениваются значения неизвестных параметров распределений, в байесовском подходе предполагается что параметры — тоже случайные величины (с точки зрения нашего незнания их значений). В качестве гипотез выступают те или иные возможные значения параметров и предполагаются данными некоторые априорные плотности неизвестных параметров . В качестве оценки неизвестных параметров выступает апостериорное распределение. Пусть в результате наблюдений получены некоторые значения изучаемой случайной величины. Тогда для значений данной выборки предполагая известным правдоподобие — вероятность (плотность) получения данной выборки при данных значениях параметров , по формуле Байеса (в данном случае непрерывный аналог этой формулы, где вместо вероятностей участвуют плотности, а суммирование заменено интегрированием) получим апостериорную вероятность (плотность) параметров при данной выборке.

Вероятность, информация и энтропия

[править | править код]Пусть имеется равновероятных исходов. Степень неопределённости опыта в этой ситуации можно характеризовать числом . Этот показатель, введённый инженером-связистом Хартли в 1928 году характеризует информацию, которую необходимо иметь, чтобы знать какой именно из равновозможных вариантов имеет место, то есть свести неопределённость опыта к нулю. Простейший способ выяснить это — задать вопросы типа «номер исхода меньше половины N», если да, то аналогичный вопрос можно задать и для одной из половин (в зависимости от ответа на вопрос) и т. д. Ответ на каждый подобный вопрос сокращает неопределённость. Всего таких вопросов для полного снятия неопределённости понадобится как раз . Более формально, номера исходов можно представить в двоичной системе счисления, тогда — это количество необходимых разрядов для такого представления, то есть количество информации в битах, с помощью которого можно закодировать реализацию равновозможных исходов. В общем случае, единица информации может быть и иной, поэтому логарифм теоретически можно использовать с любым основанием (например, если мы хотим изменять информацию в байтах, то нужно использовать логарифм по основанию 256).